Zarejestruj się do bezpłatnej platformy e-learningowej.

Zarejestruj się bezpłatnie

Sprawdź, jak Twoja strona radzi sobie w sieci!

Audytuj bezpłatnie

Spis Treści

Indeksowaniem nazywamy proces, którego efektem jest dodanie witryny, wszystkich jej adresów URL, treści oraz grafik do indeksu Google, czyli wyszukiwarki. Proces ten składa się z takich etapów, jak: wykrycie adresu URL, skanowanie oraz odczyt treści, grafik i linków zawartych pod danym adresem, a na końcu ocena, czyli dodanie strony do indeksu bądź jej odrzucenie.

Czas, jaki potrzebny jest do zindeksowania strony, wynosi od kilku godzin do kilku dni. Zazwyczaj nie musisz wykonywać dodatkowych kroków, ponieważ roboty indeksujące same z siebie rozpoczną proces skanowania i indeksacji – tak właśnie działa wyszukiwarka.

W szczególnych przypadkach, kiedy roboty mają problem z crawlowaniem strony, proces ten może potrwać nawet do kilku tygodni. Wtedy jest to wyraźny znak, że należy sprawdzić co wpływa na wydłużenie procesu indeksacji bądź jego brak.

Warto na bieżąco sprawdzać stan indeksacji serwisu, wyłapywać błędy oraz monitorować liczbę zindeksowanych adresów, szczególnie w przypadku dużych serwisów e-commerce, które dysponują szeroką gamą produktów. W tym celu możesz skorzystać z darmowych narzędzi, w szczególności tych oferowanych przez Google:

Za pomocą operatora „site” możemy w szybki sposób otrzymać listę zindeksowanych adresów. W odpowiedzi na zapytanie wyszukiwarka zwraca wszystkie obecnie zindeksowane strony danej domeny.

Istnieje wiele różnych operatorów, dzięki którym możemy zawęzić te wyniki wyszukiwania do konkretnie interesujących nas parametrów, np. wyszukiwanie jedynie zindeksowanych produktów, wpisów blogowych czy kategorii. Dla jednych serwisów może być to wykonalne, dla innych niekoniecznie – wszystko w zależności od struktury adresów URL i tagów tytułowych.

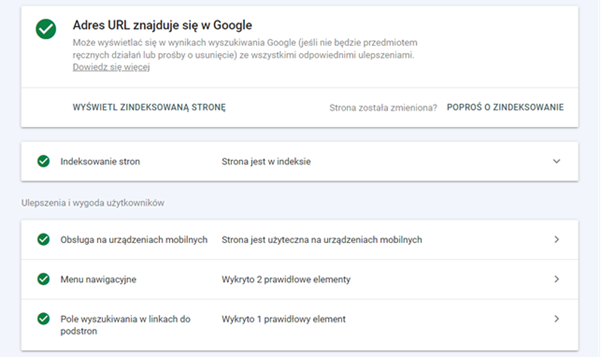

Jeden z najłatwiejszych sposobów na otrzymanie szybkiej odpowiedzi, czy strona jest zindeksowana, to ręczne sprawdzenie adresu w panelu Google Search Console. Podążając wyżej opisaną ścieżką, otrzymasz informację zwrotną o statusie adresu, wykrywalności, ostatniej dacie skanowania, obsłudze na urządzeniach mobilnych i dodatkowych ulepszeniach.

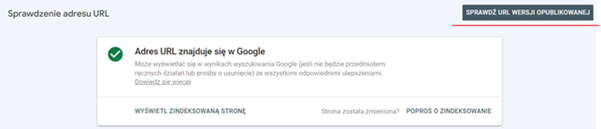

Jeżeli tutaj otrzymasz informację o tym, że Adres nie znajduje się w Google → skorzystaj z opcji sprawdzenia URL w wersji opublikowanej. Często ten pierwszy wynik może być nieaktualny, dlatego zawsze warto skorzystać z tej drugiej opcji, która da jednoznaczny rezultat.

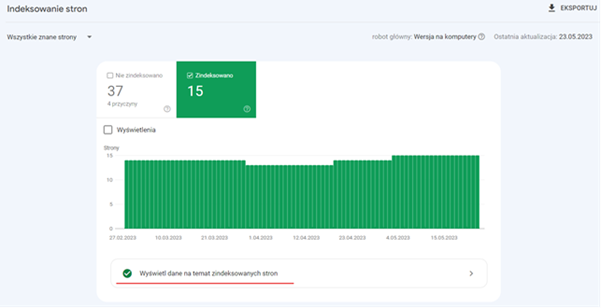

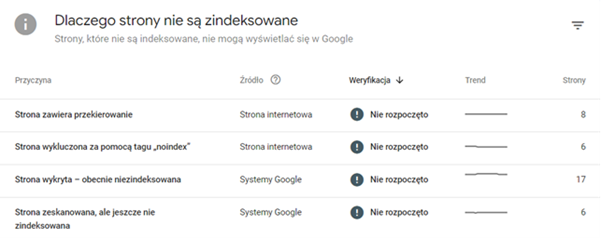

Pełny spis zindeksowanych oraz niezindeksowanych stron znajdziesz w zakładce Indeksowanie i dalej podążając ścieżką opisaną powyżej.

Z tego widoku możesz dowiedzieć się, kiedy dana strona została zindeksowana oraz jakie są przyczyny niezindeksowania pozostałych adresów. Dzięki temu możesz w prosty sposób znaleźć rozwiązanie na występujące błędy indeksacji.

Z tego widoku możesz dowiedzieć się, kiedy dana strona została zindeksowana oraz jakie są przyczyny niezindeksowania pozostałych adresów. Dzięki temu możesz w prosty sposób znaleźć rozwiązanie na występujące błędy indeksacji.

Screaming Frog w wersji bezpłatnej wykrywa do 500 adresów URL. Jeżeli więc jesteś właścicielem serwisu do 500 adresów to śmiało skorzystaj z darmowej wersji. Narzędzie przedstawi Ci listę wszystkich wykrytych adresów URL z informacją, czy są zindeksowane, czy nie. Pozwoli też wykryć różnego rodzaju błędy, które odpowiadają za brak indeksacji.

Jednym z najczęściej występujących przyczyn jest celowe (bądź nie) nadanie tagu noindex na kluczowe podstrony. Jest to wskazówka dla robotów, aby nie indeksowały tych stron.

<meta name=“robots” content=“noindex”>

Przejrzyj kod strony bądź skorzystaj z przydatnych wtyczek i sprawdź, czy nie masz nałożonego noindex na strony, które się nie indeksują. Jeżeli tak jest – wystarczy po prostu usunąć tag ze strony i zgłosić adres do ponownej indeksacji, np. za pomocą Google Search Console.

Sprawdź czy w pliku robots.txt nie ma dodanych dyrektyw, które odpowiadają blokowaniu danych stron przez robotami. Takie dyrektywy dają sygnał, aby robot nie odwiedzał wskazanych adresów. Możesz to sprawdzić poprzez wpisanie w pasek wyszukiwarki domena.pl/robots.txt.

Przeanalizuj plik .htaccess pod kątem błędnych reguł, które mogą blokować indeksowanie – podobnie jak w przypadku robots.txt – a następnie przeprować weryfikację za pomocą testera pliku robots.txt od Google.

Stosowanie linków kanonicznych może blokować indeksowanie w przypadku, kiedy na stronie, którą chcemy indeksować, dodamy tag canonical z linkiem do innej strony. Poprzez takie działanie informujemy roboty, że oryginalna treść znajduje się pod adresem kanonicznym i to ją chcemy indeksować.

Blokowanie niektórych plików przed robotami, które są kluczowe do wyświetlania się prezentowanej treści na stronie bądź blokowanie grafik przed skanowaniem może wpłynąć na odczytanie strony jako nieużytecznej i mało wartościowej, co przełoży się na brak jej indeksacji.

Strona crawlowana jest w pierwszej kolejności przez Googleboty indeksujące strony na smartfony, dlatego jeżeli strona nie jest dostosowana do urządzeń mobilnych, to prawdopodobnie nie zostanie zindeksowana. Popracuj nad użytecznością strony na wersji mobile i ponownie zgłoś stronę do indeksacji.

Zbyt długi czas odpowiedzi serwera bądź jej brak to jedne z głównych przyczyn niezindeksowanych stron. Kod odpowiedzi 5xx blokuje robotom dostęp do strony. Skontaktuj się ze swoim hostingodawcą i popraw pracę swojego serwera.

Błędnie wprowadzone przekierowania albo ich zbyt duża liczba mogą negatywnie wpłynąć na indeksację witryny bądź jej chwilowe opóźnienie.

Wykrycie przez boty zduplikowanych treści bądź stron niskiej wartości (thin content), które odznaczają się małą ilością nieużytecznej treści, skutkuje usunięciem stron z indeksu Google bądź ich utrudnioną indeksację.

Termin odnoszący się do praktyk, które nie są zgodne z wytycznymi Google. Jak można się domyśleć – stosowanie tych działań generuje problemy z indeksacją, a w szczególnych przypadkach nawet nałożenie kar.

W wyniku ataku hakerskiego i zaspamowania strony może nastąpić wyindeksowanie kluczowych podstron. Liczy się szybka reakcja i podjęcie działań mających na celu usunięcie wirusa ze strony.

Plik sitemap to zbiór wszystkich kluczowych adresów URL w obrębie całej witryny, który służy jako nawigacja dla robotów. Mówi się, że dodanie adresów do mapy stron może przyśpieszyć indeksację serwisu, szczególnie jeśli jego struktura jest dość rozbudowana. Sprawdź, czy twoja strona posiada wygenerowaną mapę i czy adresy w niej umieszczone są wciąż aktualne.

Nałożenie kary przez Google wiąże się z wyindeksowaniem serwisu a w lżejszych przypadkach jedynie spadkiem pozycji. Sprawdź, czy na Twój serwis nie została nałożona kara – informację o karach ręcznych znajdziesz w panelu Google Search Console.

Możesz niejako przyśpieszyć indeksację strony poprzez ręczne zgłoszenie adresów w Google Search Console bądź skorzystać z Indexing API. Nie działa to tak, że po zgłoszeniu strona zostanie z automatu dodana do indeksu. Zgłoszenie za pomocą tych dwóch narzędzi jest jedynie sugestią dla robotów, dodaniem ich do kolejki.

Odkrycie źródła problemu związanego z indeksacją serwisu bywa nie lada wyzwaniem. W tym artykule wymieniliśmy jedynie 13 powodów, o których najczęściej się wspomina. Lista jest o wiele dłuższa – nie raz problem może leżeć naprawdę głęboko, wtedy warto skonsultować go w większym gronie specjalistów. W końcu co dwie głowy, to nie jedna! Jeżeli zmagasz się z problemem indeksacji w swoim serwisie, skontaktuj się z nami i przekonaj się, co możemy dla Ciebie zrobić!

02.04.2025

|

czas czytania: 5:00 min

|

Inne

02.04.2025

|

czas czytania: 5:00 min

|

Inne

31.03.2025

|

czas czytania: 5:00 min

|

Inne

31.03.2025

|

czas czytania: 5:00 min

|

Inne

20.03.2025

|

czas czytania: 2:00 min

|

SEO

20.03.2025

|

czas czytania: 2:00 min

|

SEO