Zarejestruj się do bezpłatnej platformy e-learningowej.

Zarejestruj się bezpłatnie

Sprawdź, jak Twoja strona radzi sobie w sieci!

Audytuj bezpłatnie

Spis Treści

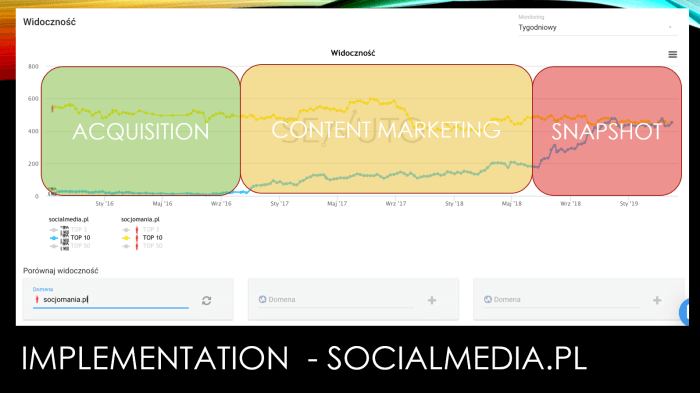

Prezentacja Łukasza Żeleznego (slajdy do pobrania na seo.london) rozpoczęła konferencję i jak sam prowadzący zapowiedział, miała pokazać widzom kilka technik, które można wykorzystać nawet „dziś wieczorem”. Jest to zatem zbiór taktyk łatwych i szybkich do wdrożenia.

Zamysł SEO SNAPSHOT opiera się na szybkim znalezieniu fraz i adresów URL z największym potencjałem do optymalizacji niezależnie od rozmiaru serwisu. Potrzebny jest dostęp do danych GSC, Google Data Studio i Excel. Za pomocą tej taktyki dotrzemy do fraz, do których nigdy byśmy się nie dokopali, gdybyśmy skorzystali tylko z danych bezpośrednio w GSC.

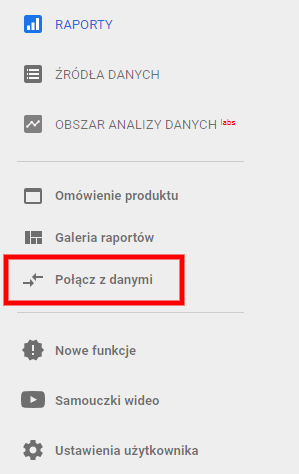

1. Zepnij Google Data Studio z danymi z Google Search Console. Następnie wybierz domenę, którą chcesz optymalizować oraz zakres danych -> Wyświetlenia adresu URL. W kolejnym oknie (Edycja połączenia) nie zmieniaj żadnych ustawień i kliknij Utwórz raport.

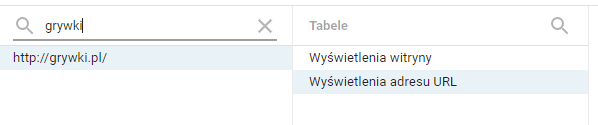

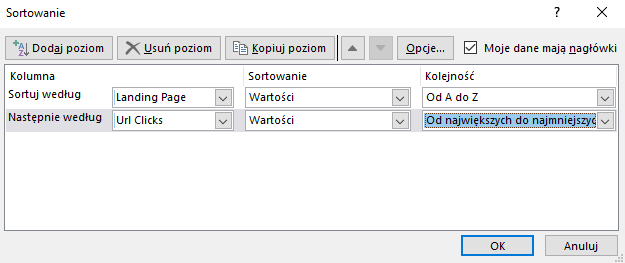

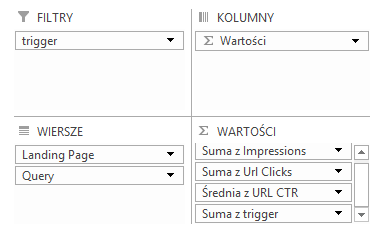

2. Wstaw do raportu tabelę i ustaw dane oraz filtry.

Wymiar: Landing Page, Query Dane: URL Clicks, Impressions, URL CTR Zakres dat: wedle potrzeby Filtr: Nie zawiera QUERY równe [brak wartości]

Tym filtrem pozbędziemy się wyświetleń zliczonych z frazami ukrytymi z powodów polityki prywatności Google.

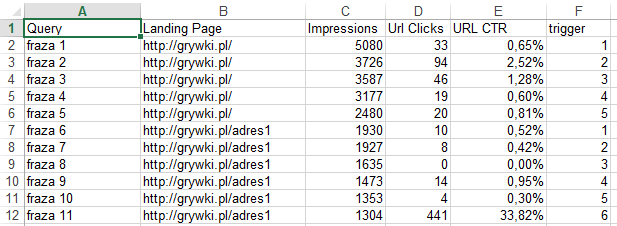

W rezultacie otrzymujemy dane posortowane według adresów URL z malejącymi kliknięciami lub wyświetleniami. Jeśli serwis jest średnich rozmiarów, ten krok tak naprawdę wystarczy. Jednak jeśli mamy do czynienia z tysiącami fraz, dane trzeba jeszcze bardziej przerobić. Na tym etapie powinny wyglądać tak:

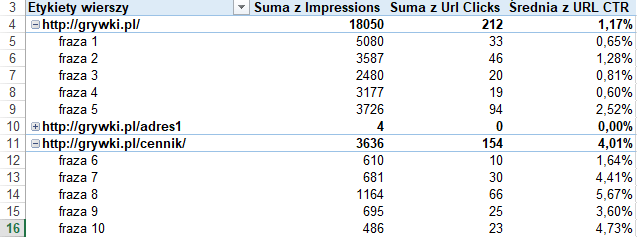

Dzięki wcześniejszym krokom otrzymujemy tabelę przestawną, która wyświetla 5 najlepszych fraz (z punktu widzenia wyświetleń albo kliknięć) dla każdego adresu URL. Przy serwisach o dużej skali w kilkanaście minut jesteśmy w stanie przygotować dane tak, aby frazy o największym potencjale były łatwe do odszukania. Tak powinna wyglądać końcowa tabela przestawna:

Pozostaje przygotowanie optymalizacji. Dla wybranego adresu URL sprawdzamy, jak wygląda optymalizacja na frazy, które znaleźliśmy. Jeśli optymalizacja jest słaba lub zupełnie jej brakuje, optymalizujemy i czekamy na wzrost pozycji. Frazy (jeśli są kluczowe) można dodać do Title, a o frazach długiego ogona wystarczy napisać dodatkowy akapit albo zmodyfikować treść tak, aby występowały w formie nieodmienionej.

Podobny model pracy nad podbijaniem słów kluczowych stosują specjaliści SEO w Artefakcie. Łukasz Żelezny podczas prezentacji pokazał kilka wykresów, które udowadniają, że ta taktyka działa. Możemy potwierdzić, że podobne rozwiązania, które stosujemy, faktycznie przynoszą efekty. Tę taktykę można by podsumować jednym zdaniem:

Wykorzystuj słowa kluczowe, które już teraz wychodzą całkiem nieźle.

Jednak wynika z tego jeszcze jeden wniosek: żeby móc zastosować SEO SNAPSHOT, musimy już mieć jakieś pozycje, by było co podbijać, a także dobry content, który będziemy jedynie uzupełniać i rozszerzać. Na pewno nie jest to taktyka, którą można wdrożyć na samym początku działania domeny.

Nie jest to także taktyka do zastosowania jednorazowo, a raczej praca cykliczna i systematyczna.

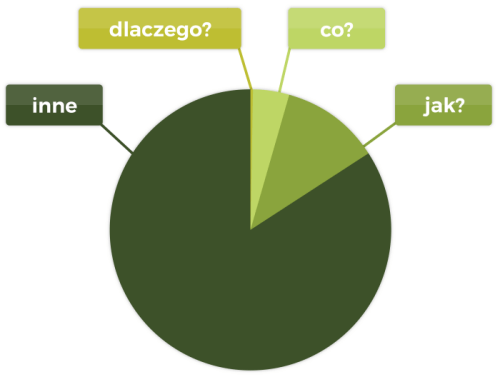

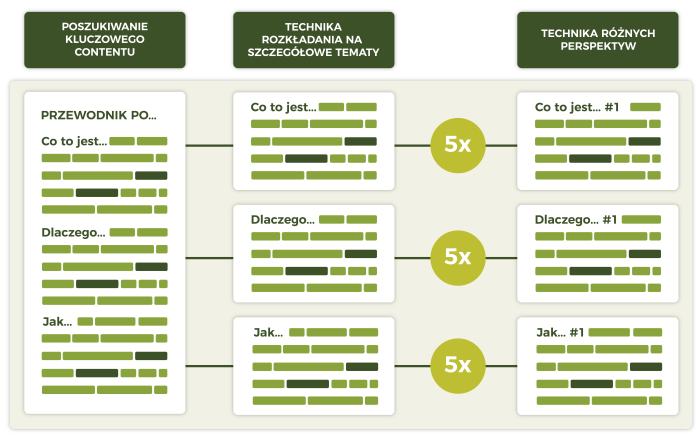

W tej części Łukasz zaprezentował, jaką wartość w wyszukiwaniu osiągają poszczególne pytania: why, what i how. Przedstawił, jakie mają znaczenie dla SEO, bazując na złotych kręgach Simona Sineka, które sugerują, że otwierając nowy biznes lub przedsięwzięcie, należy zacząć od pytania „dlaczego?”, potem należy zająć się pytaniem „jak?” i na końcu „co?”. Te zasady dotyczą projektowania usług, produktów i tworzenia generalnej wizji firmy.

Analizując ruch wielkich serwisów takich jak Hubspot i Shopify, Łukasz pokazał, że z punktu widzenia wyszukiwania w internecie najważniejsze jest pytanie JAK, dopiero potem CO i na końcu DLACZEGO. W przeciwieństwie do kręgów Simona Sineka ta kolejność odpowiada punktowi widzenia użytkownika, a nie przedsiębiorcy (sprzedawcy). Dla optymalizacji SEO to jest właśnie perspektywa, którą musimy rozpatrywać.

Taktyka, którą Łukasz zaproponował, to budowanie contentu najpierw na frazy powiązane z zapytaniem JAK. Często jest to zakres fraz o dużej liczbie wyszukań, ale stosunkowo niskiej trudności i konkurencji. Podając przykład witryny, która chciałaby wystartować w branży kart kredytowych, zdecydowanie odradził stosowanie praktycznie niemożliwych do przebicia się fraz takich jak najlepsze karty kredytowe itd. Zacząłby od fraz takich jak: jak spłacić kartę kredytową, jak działają karty kredytowe cashback itd.

Pierwsze dwie taktyki, które zaprezentował Łukasz Żelezny, dotyczyły głównie keyword research. Trzecia odnosiła się do pozyskiwania naturalnych linków. Rozwiązanie polega na docieraniu do osób i witryn linkujących do naszych profili na LinkedInie, Facebooku i Twitterze z prośbą o zmianę linków tak, aby prowadziły do naszej domeny. Giganci mediów społecznościowych zdecydowanie nie potrzebują większej puli linków, a domenom, którymi się zajmujemy, mogą bardzo pomóc. Głównymi zaletami takich linków są:

Łukasz Żelezny znany jest z przywiązywania wielkiej wagi do kwestii osiągania maksymalnych wyników w raportach GT Metrix i Google Page Speed Insights. Optymalizację prędkości na WordPressie opanował prawdopodobnie do perfekcji. Kluczowe wytyczne, które zaleca w optymalizacji:

Czy warto zastosować te zalecenia u siebie? Najbardziej dyskusyjna jest kwestia usunięcia przycisków share. Odpowiedź zależy od tego, jak bardzo naszą działalność uzależniamy od mediów społecznościowych. Dla portali newsowych i blogów przyciski share zalecałbym zostawić. Natomiast jeśli nasza obecność i działalność w social media jest drugorzędna, nie ma żadnych przeciwwskazań, aby postawić na Page Speed i pozbyć się elementów służących do dzielenia się treściami w mediach społecznościowych.

W kwestii wtyczek do WordPressa oczywiście sama ich instalacja nie wystarczy. Trzeba je jeszcze odpowiednio skonfigurować i nie ma tutaj uniwersalnych ustawień. Każdy serwis to testy od podstaw – które ustawienia faktycznie pomagają, a które powodują problemy z działaniem strony. Każde ustawienie jedno po drugim należy przetestować w narzędziach do sprawdzania szybkości działania witryn i dodatkowo przeklikać się przez serwis, aby sprawdzić, czy wszystko działa.

Z kolei zaproponowany przez Łukasza ShortPixel to jeden z głównych konkurentów wtyczki Smush. Żeby ocenić jej skuteczność, planujemy w przyszłości przeprowadzić testy i obie wtyczki dokładnie porównać. Rezultaty zaprezentujemy na naszym blogu.

Rozwiązanie bardzo często stosowanie przez specjalistów SEO. Wykorzystanie bloga lub forum, które znajduje się w subdomenie np. blog.domain.pl i przeniesienie całej tej zawartości do folderu w domenie głównej w połączeniu z zastosowaniem przekierowań 301:

Subdomena dla Google to zupełnie oddzielny byt. Jeśli już inwestujemy w widoczność, to kumulacja bloga i oferty lub produktów na jednej domenie to bardzo dobra strategia.

Bardzo treściwa prezentacja i taktyki, które faktycznie można zacząć stosować „dziś wieczorem”. Zdecydowanie warto spróbować, efekty powinny być szybko widoczne.

Magdalena Urbaniak z Brand24 przygotowała 7 sposobów na zdobycie klienta. Kluczem je łączącym jest szeroko pojęte skupienie się na odbiorcy i jego potrzebach.

Przedstawione pomysły to na pewno dobre wskazówki dla każdej działalności w sieci. Pozostaje kwestia nadania im odpowiedniej wagi w zależności od specyfiku prowadzonego biznesu.

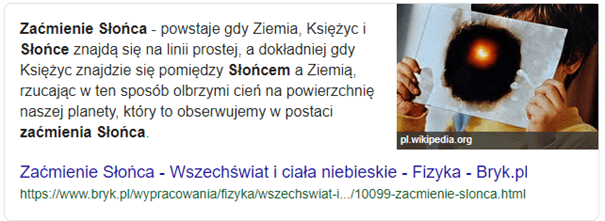

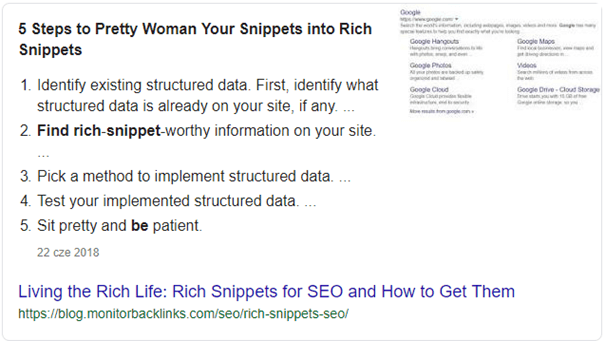

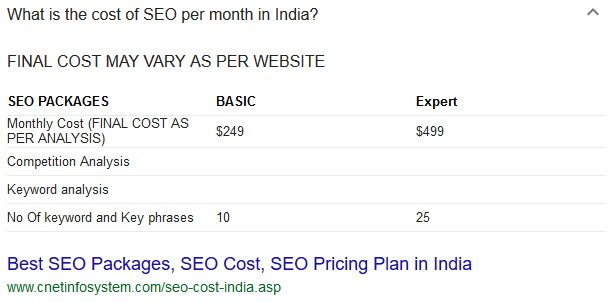

Fernardo Angulo opowiedział o badaniu, które przeprowadził SEMrush, bazując na 6,9 milionów polecanych fragmentów z odpowiedzią (featured snippets) i 80 milionach fraz. W pierwszej kolejności odpowiedział na pytanie – dlaczego fragmenty z odpowiedzią są ważne:

Następnie zaprezentowane zostały rodzaje fragmentów z odpowiedzią:

Rodzaje fraz, które znajdują się w poszczególnych fragmentach z odpowiedzią, to (dane pochodzą ze Stanów Zjednoczonych):

W tym momencie pojawiło się ciekawe odwołanie do wcześniejszej prezentacji. W snippetach w postaci listy ponad 50% treści odpowiada na pytania „jak?”, o czym wcześniej opowiadał już Łukasz Żelezny. Generalnie 41% zbadanych fraz z pytaniami posiadało fragmenty z odpowiedzią w SERP-ach.

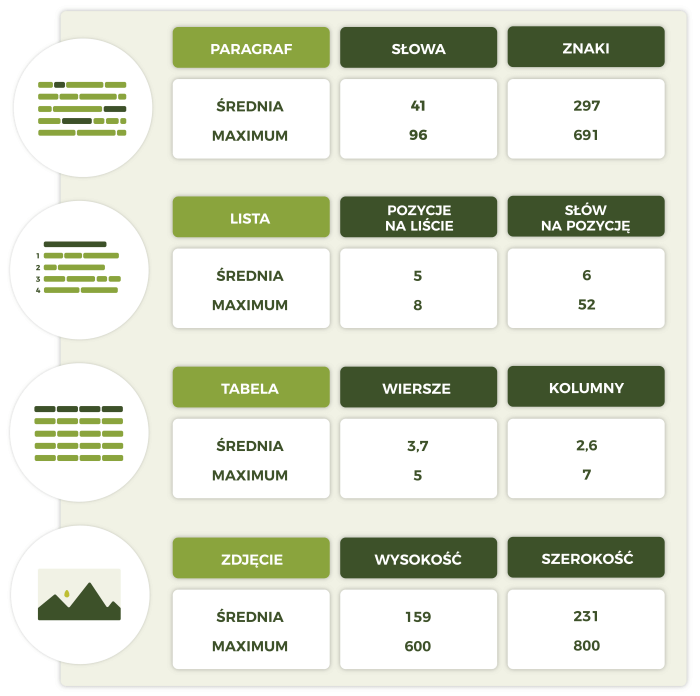

Bardzo ciekawym elementem prezentacji była analiza prezentująca, jaką treść tworzyć, aby znaleźć się w poszczególnych featured snippets

Jeśli ktoś nie był jeszcze przekonany do korzyści płynących z wyświetlania się we fragmentach z odpowiedzią, to po tej prezentacji nie powinien mieć już wątpliwości. Nie mamy oczywiście bezpośredniego wpływu na to, żeby się tam znaleźć, ale mając na uwadze te wskazówki podczas tworzenia treści realizujemy dodatkowy cel, który może przynieść nam o wiele więcej ruchu.

Steven w swojej prezentacji pokazał, jak badanie i analizowanie wielkich wpadek SEO staje się źródłem wiedzy i unikalnego doświadczenia, które lepiej zdobyć na pomyłkach innych niż we własnych projektach :). Poniżej przykłady, które przedstawił Steven wraz z krótkim omówieniem.

Opisywany przypadek dotyczył przekierowania domena.nl na domena.com/nl i jednoczesne odpalenie kilku innych wersji językowych, np. domain.com/de. Zamiast pomiędzy wersjami zrobić jedynie hreflangi i opcje wyboru języka w menu, zostały wdrożone przekierowania oparte na geolokalizacji. W związku z tym bardzo duże sekcje witryny stały się niedostępne dla konkretnych lokalizacji, a także dla robotów Google. W rezultacie witryna odnotowała znaczące spadki ruchu. Google potwierdziło wielokrotnie, że dla kierowania językowego na różne kraje najlepsze jest wykorzystanie hreflangów, nie automatycznych przekierowań, ponieważ mogą powodować problemy z indeksowaniem i być uciążliwe dla użytkowników.

Steven podkreślił, że są sytuacje, w których zdecydowałby się na przekierowania wynikające z geolokalizacji, ale w zdecydowanej większości przypadków hreflangi będą pewniejszym i lepszym rozwiązaniem.

Jak można było tego uniknąć?

Wystarczyło zaangażować specjalistów SEO na etapie koncepcji nowego kierowania językowego, a nie dopiero po drastycznych spadkach ruchu.

Paginacja w serwisie została zmieniona na obsługiwaną przez JS. Jako że witryna, której dotyczyło wdrożenie, była bardzo duża, crawl budget nie starczał na indeksowanie paginacji renderowanej w JS. Rozwiązanie to miało być przyjazne dla użytkownika, ale zdecydowanie nie było przyjazne dla robotów indeksujących, które po prostu nie dawały sobie rady z indeksowaniem wielkich zmian w strukturze i linkowaniu wewnętrznym serwisu.

Jak można było tego uniknąć?

Należało przetestować rozwiązanie, zanim zostało wdrożone w całym serwisie i zapewnić osobom je wykonującym odpowiednie szkolenie.

Wdrożenie elementów JS przesunęło linki kanoniczne w kodzie z sekcji head do body, przez co zostały one całkowicie zignorowane przez Google. Zniknięcie linków kanonicznych w serwisie, którego struktura zdecydowanie ich wymagała, spowodowała całkowity chaos z duplikacjami wewnętrznymi i kanibalizacją treści.

Jak można było tego uniknąć?

Należało przetestować rozwiązanie, zanim zostało wdrożone w całym serwisie i zapewnić osobom je wykonującym odpowiednie szkolenie.

Wszystkie „podejrzanie” wyglądające linki zostały wrzucone do disavow na podstawie artykułu przeczytanego w internecie. W rezultacie widoczność serwisu spadła drastycznie.

Jak można było tego uniknąć?

Należało skonsultować listę linków ze specjalistą SEO i wybrać (jeśli w ogóle) tylko te linki, które bez żadnych wątpliwości można było określić jako szkodliwe.

Witryna została rozbudowana o część z notkami prasowymi. Wpisy otrzymały masę linków, ale strony nie zostały zindeksowane w Google. W ich kodzie pozostały canonicale do wersji deweloperskiej.

Jak można było tego uniknąć?

Należało przetestować rozwiązanie, zanim zostało wdrożone w całym serwisie i zapewnić osobom je wykonującym odpowiednie szkolenie.

Prezentacja Srevena van Vessuma była bardzo inspirująca. Do Artefaktu też trafiają czasem klienci po katastrofach SEO. Postanowiliśmy nagrać na ten temat webinar – „Katastrofy SEO – uczmy się na błędach innych”. Odbędzie się on 18 czerwca 2019 i następnie będzie dostępny do obejrzenia na naszym profilu na YouTube.

Kolejną prezentację poprowadził Joshua Hardwick z Ahrefs. Zaczął od słów, że większość osób pozyskuje linki poprzez wpisy gościnne, ale jest wiele innych, równie skutecznych metod. Z wpisami gościnnymi wiąże się wiele problemów – potrzeby czasowe, obleganie tych samych witryn przez konkurencje, koszty wpisów czy niska jakość tych domen.

Oto lista wskazówek, których udzielił Joshua jako alternatywne i skuteczne metody pozyskiwania linków:

Korzystając z http://domaincheckplugin.com/typo, stwórz listę potencjalnych literówek związanych z twoją domeną. Wygenerowaną listę wrzuć do batch analysis w Ahrefs i zbadaj, czy do któreś z tych domen (zazwyczaj tak naprawdę nieistniejących) nie prowadzą linki, których intencją była twoja domena.

Prezentacja zawierająca kilka ciekawych pomysłów, jak inaczej niż zwykle można podejść do tematu pozyskiwania linków dobrej jakości. Jeśli wcześniej podejście tego typu nie było rozpatrywane, zdecydowanie warto je wypróbować.

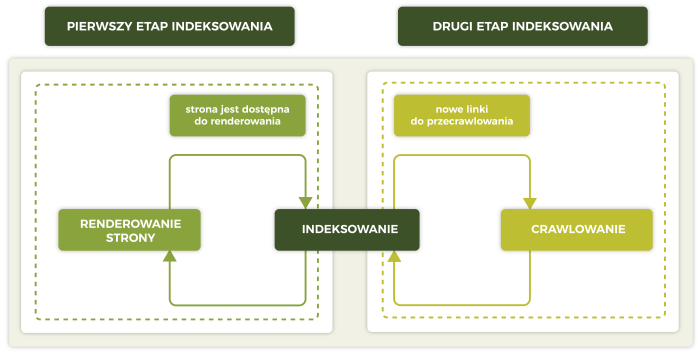

W kolejnej prezentacji Maria Cieślak opowiedziała o trudnościach i korzyściach płynących z migracji na JS. Już na samym początku zaznaczyła, że na ten moment wyszukiwarki inne niż Google i Ask.com nie poradzą sobie z indeksowaniem witryny w całości opartej o JS. Co więcej, Google do renderowania nie używa najnowszej wersji przeglądarki, zatem najświeższe funkcjonalności mogą się po prostu nie indeksować prawidłowo. Poniższy schemat przedstawia, jak wygląda proces indeksowania JS przez Google:

Głównym problemem wynikającym z tego procesu jest czas potrzebny do jego zrealizowania. URL zindeksuje się szybko, ale zawartość w JS trafi do indeksu nawet dopiero po kilku tygodniach.

Na szczęście istnieją rozwiązania, które mogą nam w tym pomóc:

Strony w JS dają nam ogromne możliwości, ale prawidłowa migracja i wprowadzenie JS są czasochłonne i kosztowne. Dlatego najważniejsze jest, aby zadać sobie najpierw pytanie – czy naprawdę potrzebuję JS?

Na bazie naszych doświadczeń z codziennej pracy z klientami, których witryny oparte są na JS, wiemy, jakie problemy z SEO potrafią się pojawić oraz jaki nakład pracy i finansów może być potrzebny, aby sobie z nimi poradzić. Dlatego zgodnie z tym, co powiedziała Maria, nie zalecamy przechodzenia na JS, jeżeli nie jest to niezbędne. A jeśli już jest to konieczne, proces należy perfekcyjne zaplanować i przeprowadzić, inaczej narażamy się na negatywne efekty.

Gianluca zaczął swoją prezentację od zaznaczenia, że w przeciwieństwie do innych prelegentów nie jest reprezentantem Ahrefs, SEMrush czy innego giganta, dlatego nie ma możliwości prowadzenia badań i analiz na ogromną skalę. To, co pokazał, bazowało jego doświadczeniu, kilku eksperymentach oraz intuicji.

Genezą prezentacji był Tweet, który Gianluca opublikował w październiku 2018. Wpis i dyskusja, którą wywołał, toczyła się wokół założenia, że najlepszym miejscem na zrozumienie zmiany wprowadzanych przez Google w algorytmie są bezpośrednio strony wyników wyszukiwania. W ostatnich latach w dużej mierze zmiany te dotyczą tzw. „search intent”, czyli odczytywania intencji użytkownika w momencie wpisywania konkretnej frazy.

Parafrazując znaczenie SERP, można powiedzieć, że to zbiór dokumentów ocenionych przez Google jako najbardziej odpowiednie (z ang. relevant) dla danego zapytania.

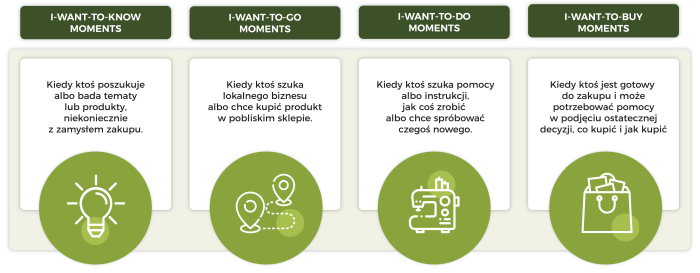

Gianluca swoją analizę intencji wyszukiwania opiera o zaprezentowane przez Google Micro-Moments:

Na ich bazie przygotował własną infografikę, jak Google ocenia stosowność treści do zapytania.

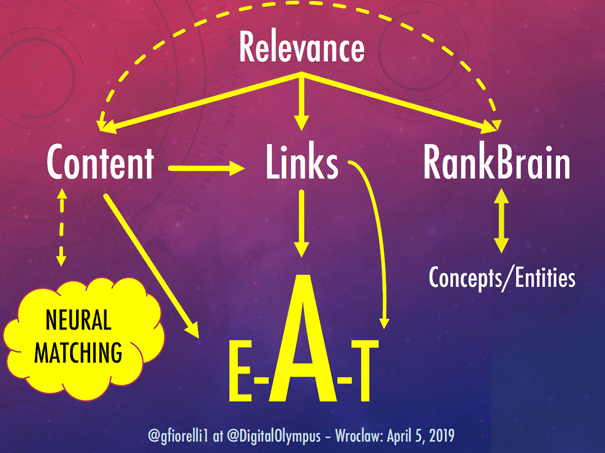

Infografika pokazuje 3 główne grupy czynników, o których mówił Gianluca:

Opisując tę koncepcję, w skrócie można powiedzieć, że dobry content, ważny dla zagadnienia, jest źródłem autorytetu i przyrostu linków, których istnienie dalej wzmacnia nasz autorytet. Do contentu i linków dochodzi trzeci czynnik, czyli prawidłowe odczytanie znaczeń i kontekstu przez RankBrain. Strony spełniające te założenia będą wyświetlać się wysoko w wynikach wyszukiwania.

Badając interesującą nas branżę albo frazy, możemy pogłębić analizę poprzez przejrzenie, co Google pokazuje w podobnych wyszukiwaniach (kiedy wejdziemy na stronę i zaraz wrócimy do listy wyników) i podpowiedziach Google (autouzupełnianie przy wpisywaniu zapytania).

W ostatniej części prezentacji Gianluca zwrócił uwagę na to, żeby podczas procesu szukania słów kluczowych korzystać z różnych narzędzi, które uwzględniają CPC. Niskie wartości CPC sugerują, że może to być zapytanie informacyjne. Jednakże jeśli są większe niż 0, to intencją wyszukiwania powiązaną z tym słowem kluczowym może być także zakup.

Przykład stanowią frazy „Wrocław”, „Warszawa” i inne zapytania o miasta. Będąc w TOP10 na takie zapytania (albo w wynikach płatnych, jeśli wynik organiczny będzie bardzo trudny do osiągnięcia), pozostajemy już w pamięci użytkownika, który wstępnie szukał informacje o destynacji, do której chciałby się udać.

Czy warto sięgać po takie słowa kluczowe, mając na uwadze budowę rozpoznawalności marki? Trudne pytanie, gdyż koszty takich działań mogą przekroczyć ich zwrot. Dla hotelu w mniejszej miejscowości wyświetlanie się w TOP5 na frazę np. „Kutno” może przynosić korzyści, ale mimo niskiej konkurencji osiągniecie takiej pozycji może nie być takie proste.

Trzecią wskazówką od Gianluci to analizowanie wyników pod kątem tego, jaka najczęściej jest intencja użytkownika wpisującego dane zapytanie. Google rejestruje CTR na takie zapytania i w rezultacie najwyżej wyświetla grupy wyników z intencją, która jest najczęściej wybierania. Jeśli mamy wątpliwość, czy dana fraza sprawdzi się sprzedażowo – sprawdźmy SERP-y. To, czy zobaczymy produkty, direct answers czy featured snippets, wiele mówi nam o intencji wyszukiwania. Tak samo to, czy zobaczymy wyniki lokalne i mapy, czy tylko wyniki globalne, wiele powie nam o intencjach lokalnych. Z kolei jeśli na ważne dla nas zapytania pojawiają się obrazy, newsy albo wideo, to też jest podpowiedź, na jakim polu powinniśmy jeszcze powalczyć o widoczność.

Strony wysoko w SERP-ach mówią nam, jaka jest najpopularniejsza intencja użytkownika wpisującego daną frazę, jaki format zawartości jest najbardziej odpowiedni (treść, grafiki, wideo) oraz czy Google traktuje dany temat lokalnie. Co więcej, klasyczny podział treści nie zawsze jest skuteczny, coraz częściej trzeba umiejętnie łączyć i mieszać wszystkie te elementy.

Miłosz w swojej prezentacji pokazał 7 taktyk i trików ze swoich doświadczeń i eksperymentów, które można wykorzystać przy pracy nad poprawą widoczności witryny.

Pobierając dane z Wayback Machine do Google Data Studio, można łatwo stworzyć listę wszystkich zasobów, które odpowiadają kodem 404. Po wyfiltrowaniu plików .js, .css i pozostawieniu HTML (ale też np. obrazków i wideo) tworzymy listę historycznych podstron serwisu, niezależnie czy teraz istnieją w indeksie jako 404, czy już od dawna zniknęły. Następnie przekierowujemy te adresy na obecnie istniejące w serwisie.

Czy ta technika faktycznie przynosi wzrosty? Wyniki naszych testów są podzielone, na pewno dalej będziemy badać temat. Natomiast w kwestii historycznych adresów znaczenie mają przede wszystkim te, które są podlinkowane i nie przekazują nigdzie tej mocy. Pod tym kątem serwis możemy sprawdzić znacznie szybciej, korzystając chociażby z Ahrefsa lub Majestica.

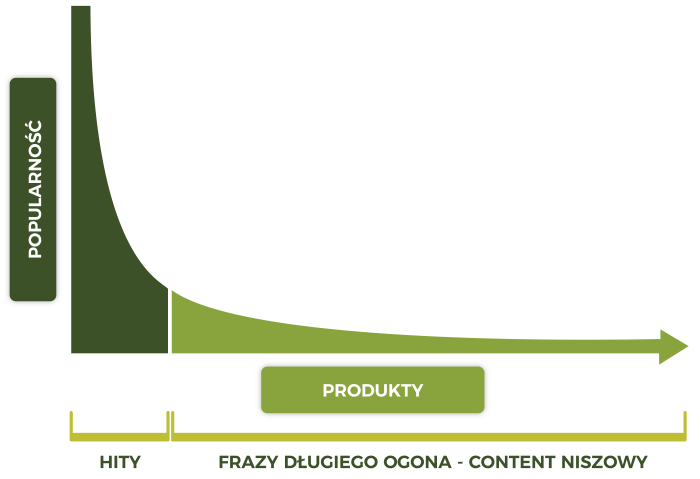

Już na początku tematu Miłosz zaznaczył, że nie mówimy tutaj o długim ogonie w znaczeniu takim jak o frazach długiego ogona w nomenklaturze SEO. Omawianym zagadnieniem jest trend statystyczny mówiący o sprzedaży dużej liczby produktów, które nie są hitami.

Zasada mówi o tym, że dostatecznie duża liczba produktów niszowych przekroczy sprzedaż wąskiego grona hitów. Miłosz zaproponował przeniesienie tej zasady na lokalne SEO. Często robiąc keyword research na frazy lokalne np. „księgowy Warszawa”, widzimy w narzędziach zapytania przede wszystkim dla Warszawy i długi ogon o małej ilości zapytań dla największych pobliskich miejscowości i dzielnic. Ta taktyka polega na przygotowaniu pozycjonowania lokalnego na wszystkie biznesowo istotne lokalizacje, nawet jeśli narzędzia nie pokazują zapytań. Wyszukujemy słowa kluczowe na dzielnice, osiedla miast i wszystkie pobliskie miejscowości, które biznesowo są w zasięgu. W rezultacie bardzo szybko można osiągnąć TOP 3, a nawet TOP 1 na dziesiątki zapytań. Nawet jeśli w skali roku każdy taki landing page ma przynieść 1 lub 2 klientów, to biorąc pod uwagę ich liczbę, zaczyna nabierać to sensu. Zasady, których musimy się trzymać, realizując Long Tail Effect:

Miłosz podał kilka trików do zastosowania przy kampaniach mailingowych:

Aby dane w Google Analytics były wiarygodne, Miłosz zachęcił słuchaczy, aby tworzyli własne listy filtrów do GA, które będą filtrować spam i boty, i podłączali je do widoku głównego. Przy tworzeniu listy filtrów pomocne mogą być narzędzia takie jak Ghost Spam Blocker, które po podpięciu do GA w kilka minut są w stanie przygotować pokaźne listy filtrów automatycznie.

Korzystając z Brand24, warto analizować, czy użytkownicy odnoszą się pozytywnie, czy negatywnie do określonych tematów. Możemy zbadać, kto pisze na dany temat, w jakim kontekście oraz kto jest np. największym pozytywnym influencerem dla danej domeny.

Miłosz od razu zaznaczył, że jest to eksperyment i jego wdrażanie może być czasem niebezpieczne. Powiedział, że posiada bazę 157 tysięcy spamerskich domen zdobytych na bazie analizy linków zwrotnych setek serwisów. Eksperyment, który zaproponował, to profilaktyczne wrzucenie losowych 100 adresów z tej listy do disavow np. nowej domeny na biznes lokalny, która nie była z nich linkowana.

Miłosz co prawda zaprezentował przykładowe wzrosty dla domeny, w której umieścił taki plik, w naszej ocenie jednak jest to pomysł, do którego należy podchodzić z dystansem. Obecnie prowadzone przez nas testy nie pokazują takiej zależności, jakoby wrzucanie losowych złych domen do disavow miało przynosić pozytywne efekty. Na pewno poddamy to dalszym testom i jeśli wnioski będą obiecujące, napiszemy o tym oddzielny artykuł.

Ostatnia rada Miłosza – nigdy nie kupuj linków z list linków, które są dostępne dla wszystkich. Treść tam nie jest moderowana i niskiej jakości, często serwisy nie posiadają ruchu organicznego, a ich tematyczność jest bardzo ogólna, przez co nie posiadają autorytetu w niszy, której tak naprawdę szukamy.

Miłosz zaprezentował pomysły, z których cześć okazała się wyjątkowo nowatorska i oryginalna. Są świetną inspiracją do własnych testów i eksperymentów.

Stacey w swojej prezentacji mówiła przede wszystkim o pomysłach (nie tylko treść, także infografiki, filmiki itd.), które rujnują content i kampanie marketingowe. Przytoczyła badanie Buzz Sumo, które udowodniło, że większość artykułów publikowanych w internecie nie pozyskuje żadnych linków, gdyż są po prostu słabe. Skąd bierze się zatem słaby i bezużyteczny content? Do najważniejszych powodów Stacey zaliczyła poniższe problemy:

Do każdego z tych problemów Stacey zaproponowała elementarne rozwiązania:

Prezentacja dotyczyła głównie strategii contentowych, ale rady dotyczące organizacji kreatywnej pracy zespołowej odnoszą się do wszystkich branż i z tej perspektywy polecam je rozpatrywać.

Deepak Shukla poprowadził bardzo inspirującą prezentację na temat promocji własnej marki i własnego nazwiska. Świetnym przykładem wartości takiej promocji jest to, że jak się szybko okazało, każdy ze słuchaczy przed przyjazdem przeglądał listę prowadzących i to skład w dużej mierze zaważył na decyzji o zakupie biletów. Nazwiska i marki mają ogromne znaczenie.

Deepak zachęcał do promocji własnego nazwiska, własnej marki. Powiedział, że dla jego agencji najważniejszym i najlepszym klientem są oni sami. Najważniejsza, najdroższa i najopłacalniejsza jest promocja ich własnej marki, są swoim klientem numer 1. Jako przykłady świetnej autopromocji Deepak podał kilka przykładów: Noah Kagan, Gary Vaynerchuk, Tai Lopez, Larry Kim – to osoby, których nazwiska przerosły brandy, od których zaczynali.

Oczywiście budowanie marki osób zamiast brandu nie jest skuteczne w każdej branży. Natomiast może okazać się dobrą taktyką w marketingu, gdzie dla potencjalnego klienta nośnikiem produktu, niezależnie czy jest to kampania marketingowa, czy szkolenie, jest właśnie specjalista albo freelancer, z którym będzie bezpośrednio współpracował.

Hasłem podsumowującym prezentacje jest – KNOW MY NAME. Przesłaniem Deepaka było skłonienie specjalistów, aby pomyśleli inaczej o swojej przyszłości w branży i zaczęli budować rozpoznawalność nie tylko swoich klientów, ale także swojego własnego nazwiska. Coś, od czego każdy może zacząć choćby i dziś – to prowadzenie własnego bloga eksperckiego.

Słowem wstępu odnoszącym się do prezentacji Deepaka Shukli, która odbyła się kilka minut wcześniej, Jason Barnard podsumował swoje działania marketingowe skupiające się na jego nazwisku jako słabe, gdyż jak się okazało, musiał przedstawiać się innym prezentującym. Obiecał jednak poprawę i wzięcie do serca tego, o czym opowiadał Deepak :).

Jako filary zaistnienia w chaosie, który stanowi internet, Jason wymienił 3 elementy:

Cytat, który Jason wyróżnił podczas wprowadzania do tematu, brzmi:

Entities are the single most important concept to undestand in SEO right now.

Google dodatkowo określa byty jako:

A thing or concept that is singular, unique, well-defined and distinguishable.

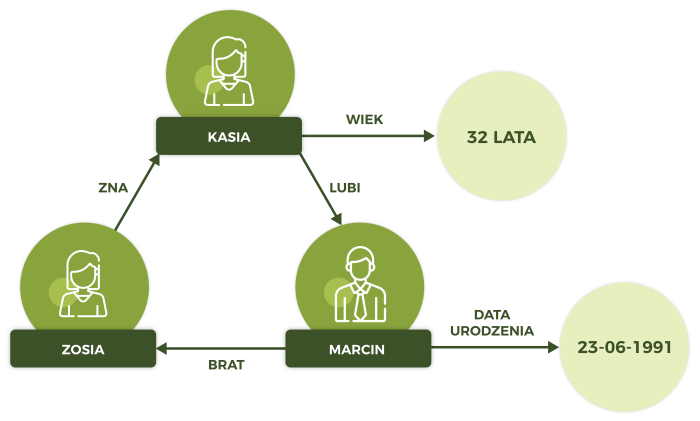

A zatem nie tylko osoby albo przedmioty, ale także pojęcia takie jak kolor, data, idea i wiele więcej.

Wszystkie te byty mają określone relacje i atrybuty, a dopiero ich określenie pozwala zrozumieć istotę opisywanych bytów.

Dodawanie do witryny danych strukturalnych, z których interpretacją Google sobie radzi, nie jest wcale zbędnym zadaniem. Dzięki takim działaniom w skali globalnej zrozumienie istoty pojęć i zapytań staje się dla Google o wiele prostsze. Miejsce, gdzie algorytm był pewny swojej interpretacji w 40%, staje się pewne w 70%, a w końcu w 100% i działa to na naszą korzyść. Podczas tej części prezentacji pojawił się także temat AEO, czyli Answer Engine Optimization.

Dane z klasycznych list i tabeli są dla Google bardzo ważne, ponieważ posiadają strukturę. Z kolei problemem jest rozróżnienie, które tabele zawierają dane, a które wstawione są tylko dla wyglądu. Aby ułatwić robotom rozróżnienie, zaleca się do danych stosować <table> a do designu <div>. Dodatkowo zarówno z punktu widzenia UX, jak i SEO ważne jest podpisanie tabeli danych krótkim tekstem.

Elementy DOM, czyli np. znaczniki HTML, są również ważne z punktu widzenia robotów indeksujących strony. Kluczowa jest konsekwencja w budowaniu zawartości i prawidłowe wykorzystanie znaczników header, nav, main, section, aside i footer, aby pokazać algorytmowi, gdzie znajdują się najważniejsze na stronie treści.

Kolejnym pomocnym rozwiązaniem zasugerowanym przez Jasona jest AMP. Standard AMP HTML jest nie tylko szybki, ale posiada bardzo dobrą i prostą strukturę. Wdrożenie go to kolejny krok w stronę usystematyzowania zawartości serwisu.

Jason wspomniał jeszcze jedną ważną rzecz, o której mało osób wie. Google i WordPress oficjalnie podjęli współpracę, aby strony tworzone na WordPressie były nie tylko szybsze, ale w sposób automatyczny posiadające taką strukturę, aby była dla Google czytelna tak jak obecnie jest np. Wikipedia.

Ciekawostką okazał się także temat pisania tekstów w sposób odpowiadający warunkom interpretacji byt > relacja > byt. Na przykład Apple produkuje iPhony.

Złą budową treści utrudniamy robotom interpretację tekstu. Przykład złego powiązania:

Sarenza – Francuska, Paryska firma założona w 2005 przez Francisa, Yoan i Franka, sprzedaje w Europie buty dla mężczyzn, kobiet i dzieci.

Oraz przykład prawidłowego połączenia ze sobą bytów i relacji, które są dla nas kluczowe:

Francuska firma z siedzibą w Paryżu, założona w 2005 przez Francisa, Yoan i Franka – Sarenza sprzedaje buty dla mężczyzn, kobiet i dzieci w Europie.

Droga do rozbudowy treści, którą zaproponował Jason, nie polega tylko na umieszczaniu synonimów słowa kluczowego, ale także słów, które Google oczekuje jako wynikające z kontekstu.

To kontekst nadaje znaczenie poszczególnym słowom kluczowym. Do tworzenia takiej treści świetnym narzędziem jest Surfer SEO, gdzie szybko i sprawnie jesteśmy w stanie sprawdzić słowa i frazy wspólne dla wyników z TOP 10 dla danego zapytania.

Internet to największa baza danych w historii świata, lecz niestety bardzo źle zorganizowana. Organizujmy nasze małe zakątki sieci w sposób rzetelny, a Google będzie nam wdzięczny. Dzięki temu łatwiej będzie nam przekonać wyszukiwarkę, aby to naszą zawartość wyświetlała jak najwyżej.

Prezentacja Navah jako jedyna dotyczyła bezpośrednio PPC, a dokładnie Quality Score, który przyznaje Google. Średnia wartość dla 63 tysięcy kont z USA w trzecim kwartale 2018 to 5.6/10.

Wysoki Quality Score pozwala zmniejszyć koszty kliknięć w Google Ads i zwiększyć liczbę wyświetleń, jednocześnie zwiększając CTR. Jednakże analiza wykonana przez Navah pokazała, że dla kampanii niebrandowych wyniki nie są wcale tak oczywiste.

Samo posiadanie wysokiego Quality Score nie gwarantuje sukcesu kampanii.

Quality Score to ważny element, ale nie jest kluczowym wskaźnikiem efektywności kampanii.

Hannah zaczęła prezentację od opisania sytuacji, którą zna chyba każdy specjalista SEO. A mianowicie ignorowanie przez klientów pracy nad strukturą witryny do momentu, kiedy wszystko zacznie się sypać. Niestety świadomość tego, że struktura jest fundamentem wskazującym na to, jak użytkownicy i roboty rozumieją witrynę, jest bardzo mała.

Hannah podzieliła swoje wskazówki na dwie grupy – podstawowe, istniejące od dawna dobre praktyki oraz praktyki, które zaczęły wymuszać na nas m.in. zmiany w algorytmach.

To była jedna z tych prezentacji, których nie da się zamknąć w 20 minutach. Kilka zagadnień ewidentnie wymagałoby oddzielnych prezentacji. Niektóre zagadnienia w przyszłości podejmiemy na naszym blogu lub webinarach.

Zdecydowanie tak! Jak wspomniałem na początku, na konferencji zaprezentowano jedne z najlepszych prezentacji, które w ostatnim czasie widziałem. Ich różnorodność zapewniła, że każdy znalazł coś dla siebie – dowiedział się o czymś nowym lub zainspirował się do przeprowadzenia własnych testów. Czekamy na kolejne edycje!

02.04.2025

|

czas czytania: 5:00 min

|

Inne

02.04.2025

|

czas czytania: 5:00 min

|

Inne

31.03.2025

|

czas czytania: 5:00 min

|

Inne

31.03.2025

|

czas czytania: 5:00 min

|

Inne

20.03.2025

|

czas czytania: 2:00 min

|

SEO

20.03.2025

|

czas czytania: 2:00 min

|

SEO