Zarejestruj się do bezpłatnej platformy e-learningowej.

Zarejestruj się bezpłatnie

Sprawdź, jak Twoja strona radzi sobie w sieci!

Audytuj bezpłatnie

Spis Treści

Algorytmy Google to skomplikowane zestawy reguł i równań matematycznych używane do sortowania, interpretowania i prezentowania danych w usługach Google. Najbardziej znane z nich decydują o tym, jakie strony internetowe pojawiają się na czołowych pozycjach w wynikach wyszukiwania na określone zapytania. Mają kluczowe znaczenie zarówno dla sposobu działania samej wyszukiwarki, jak i użytkowników Internetu na całym świecie.

Zrozumienie działania algorytmów Google jest kluczowe dla skutecznego SEO (Search Engine Optimization) i SEM (Search Engine Marketing). Dzięki temu możemy optymalizować treści naszych stron internetowych, aby lepiej odpowiadały na kryteria wyszukiwania i uzyskiwać wyższą pozycję w rankingu, co z kolei prowadzi do zwiększenia ruchu oraz grona potencjalnych klientów. Algorytmy umożliwiają personalizowanie treści i reklam, co jest korzystne zarówno dla użytkowników, jak i marketerów. Internauci otrzymują bardziej trafne i interesujące informacje, a reklamodawcy mogą skutecznie zwiększać konwersję. Google używa algorytmów również do optymalizacji wielu swoich usług, w tym Google Maps, YouTube, Google News i innych.

Algorytmy Google są regularnie aktualizowane i dostosowywane do zmieniających się wytycznych. Dlatego ważne jest, aby być na bieżąco z najnowszymi trendami i dostosowywać strategie marketingowe do potrzeb użytkowników, co na pewno wpłynie na nasze strategie dotyczące pozycjonowania stron. Można to osiągnąć poprzez śledzenie branżowych blogów, uczestnictwo w konferencjach SEO oraz wykorzystanie narzędzi analitycznych do monitorowania efektów naszych działań.

Algorytmy Google mają ogromny wpływ na wyniki wyszukiwania, a ich rola jest kluczowa w określaniu, jakie strony internetowe są wyświetlane użytkownikom oraz w jakiej kolejności. Oto niektóre z głównych aspektów, o których decydują.

Najważniejszą funkcją algorytmów Google jest ocena i tworzenie rankingu witryn. Analizują strony pod wieloma kątami, biorąc pod uwagę jakość treści, użyteczność dla użytkownika, autorytet strony (częściowo mierzony liczbą i jakością linków z innych serwisów), słowa kluczowe, strukturę strony i wiele innych czynników.

Algorytmy określają, jak dobrze strona pasuje do zapytania użytkownika. Obejmuje to analizę słów kluczowych oraz zrozumienie zamiaru wyszukiwania, czyli próbę dostarczenia tego, czego użytkownik szuka (informacji, konkretnego produktu, usługi, itp.).

Google personalizuje wyniki wyszukiwania na podstawie danych o użytkowniku, takich jak jego poprzednia aktywność w wyszukiwarce, historia, lokalizacja geograficzna i urządzenie, z którego korzysta. Oznacza to, że dwie różne osoby mogą otrzymać różne wyniki wyszukiwania na to samo zapytanie.

Algorytmy Google są stale aktualizowane, aby przeciwdziałać próbom manipulacji wynikami wyszukiwania (takim jak upychanie słów kluczowych czy sztuczne linkowanie), co jest znane jako techniki Black Hat SEO. Google stara się promować treści, które są autentyczne i wartościowe dla użytkowników.

Roboty Google oceniają także szybkość ładowania się stron oraz ich użyteczność, zwłaszcza na urządzeniach mobilnych. Witryny, które wczytują się szybko i są responsywne, mają tendencję do osiągania wyższych pozycji w wynikach wyszukiwania.

Dla firm i twórców treści oznacza to, że zrozumienie i dostosowanie się do algorytmów Google jest kluczowe dla uzyskania wysokiej widoczności w Internecie.

Algorytmy Google są stale rozwijane i aktualizowane, aby sprostać zmieniającym się wytycznym, potrzebom użytkowników i wyzwaniom technologicznym. W praktyce oznacza to:

Właściciele stron internetowych, twórcy treści oraz specjaliści SEO muszą być na bieżąco z najnowszymi aktualizacjami i dostosowywać swoje strategie do bieżących wytycznych. Nie istnieje jednak stały zestaw reguł pozycjonowania witryn w wyszukiwarce, ponieważ zasady te są ciągle rozwijane i zmieniane.

Panda odnosi się do jednej z ważnych aktualizacji algorytmu Google, wprowadzonej po raz pierwszy w 2011 roku. Głównym jej celem było poprawienie jakości wyników wyszukiwania poprzez obniżenie rankingu stron o niskiej wartości, a jednocześnie promowanie witryn o wysokiej użyteczności. Serwisy z treścią uważaną za cenną, oryginalną i przydatną otrzymują lepszą pozycję, podczas gdy strony zawierające duplikaty lub content o nadmiernym nasyceniu słowami kluczowymi są degradowane w wynikach wyszukiwania.

Algorytm Panda penalizuje witryny, które mają mało oryginalnej treści lub nie wnoszą wartości dla użytkownika. Często określane są jako „thin content” i mogą obejmować serwisy z bardzo małą ilością autorskiego tekstu. Ocenie podlega jakość całej strony internetowej, a nie tylko pojedynczych podstron. Wymusiło to na właścicielach skupienie się na tworzeniu wartościowych, unikalnych i angażujących treści, zamiast stosowania technik SEO skoncentrowanych na ilości i nasyceniu słowami kluczowymi. Było to istotne, ponieważ pomogło poprawić ogólną jakość informacji dostępnych w Internecie.

To kolejna aktualizacja algorytmu wyszukiwarki Google, wprowadzona w kwietniu 2012 roku. Jego głównym celem jest identyfikowanie i obniżanie pozycji stron internetowych, które stosują techniki manipulacji rankingiem w wynikach wyszukiwania (tzw. Black Hat SEO). Pingwin koncentruje się głównie na profilach linków prowadzących do witryn, analizując je pod kątem jakości i naturalności. Odnośniki zakupione lub pochodzące z sieci i wymiany linków, mogą negatywnie wpłynąć na widoczność serwisu. Penalizacji podlegają również te strony, które wykorzystują agresywne techniki SEO, w tym nadmierne optymalizowanie tekstów kotwiczących (anchor text) i stosowanie sztucznych metod budowania linków.

Początkowo Pingwin aktualizowany był rzadko, co oznaczało, że strony mogły czekać miesiące na odzyskanie wysokiej pozycji w rankingu po dokonaniu poprawek. Jednak od wersji 4.0 (wprowadzonej w 2016 roku) algorytm działa w czasie rzeczywistym, co oznacza, że zmiany w następują znacznie szybciej po poprawie profilu linków. Pingwin zmobilizował właścicieli stron internetowych do stosowania etycznych i zrównoważonych praktyk SEO, skupiając się na budowaniu naturalnych profilów linków i tworzeniu wartościowych treści.

Koliber (Hummingbird) to aktualizacja algorytmu wyszukiwarki Google, wprowadzona w 2013 roku. Został zaprojektowany, aby lepiej rozumieć zapytania użytkowników, zwłaszcza te zadawane w formie pytań lub złożonych zdań, a także rozpoznawać synonimy i kontekst haseł. Zamiast na pojedynczych słowach kluczowych koncentruje się na całych wyrażeniach interesujących internautę. Bada intencję stojącą za zapytaniem, co pozwala na lepsze dopasowanie wyników do rzeczywistych potrzeb użytkownika.

Algorytm ten został zaprojektowany z myślą o rosnącej popularności wyszukiwania głosowego i zapytań w formie rozmowy. Pozwala to na lepsze radzenie sobie z dłuższymi i bardziej naturalnymi wyrażeniami, które często zawierają dodatkowe słowa pomocnicze. Koliber próbuje zrozumieć ogólny sens zapytań, zwłaszcza tych skomplikowanych lub formułowanych w naturalnym języku, co umożliwia dostarczanie bardziej trafnych i użytecznych wyników wyszukiwania. Dla właścicieli stron internetowych i twórców treści oznacza to konieczność skupienia się na tworzeniu wartościowego i informacyjnego contentu.

RankBrain to część algorytmu wyszukiwania Google, wprowadzona w 2015 roku, która wykorzystuje sztuczną inteligencję (AI) i uczenie maszynowe do lepszego rozumienia zapytań użytkowników oraz dostarczania bardziej trafnych wyników wyszukiwania. Pomaga Google interpretować niejednoznaczne lub skomplikowane wyrażenia, a nawet język naturalny, który zawiera słowa lub frazy wcześniej niestosowane. Algorytm wykorzystuje technologie uczenia maszynowego, co oznacza, że jest zdolny do samodzielnego doskonalenia swojego rozumienia zapytań na podstawie danych, które przetwarza. To pozwala mu na ciągłe udoskonalanie swojej zdolności do interpretacji potrzeb internautów.

Szczególnie istotna jest rola RankBrain w obsłudze zapytań, których Google nigdy wcześniej nie przetwarzał – szacuje się, że codziennie pojawia się ich około 15%. Algorytm zmienił też nieco podejście do optymalizacji pod wyszukiwarki (SEO). Zamiast skupiać się wyłącznie na słowach kluczowych, ważne stało się tworzenie treści, które rzeczywiście odpowiadają na potrzeby i zamiary użytkowników.

BERT (Bidirectional Encoder Representations from Transformers) to zaawansowana metoda przetwarzania języka naturalnego (NLP) opracowana przez Google i wprowadzona w 2019 roku jako część ich algorytmu wyszukiwania. Został zaprojektowany tak, aby lepiej rozumieć kontekst słów w zapytaniach użytkowników, co pozwala na bardziej trafne dopasowywanie wyników.

Tradycyjne metody przetwarzania języka naturalnego analizowały zapytania słowo po słowie w kolejności liniowej. BERT natomiast działa w sposób dwukierunkowy. Oznacza to, że rozumie kontekst każdego słowa w wyrażeniu na podstawie wszystkich pozostałych słów w zdaniu, nie tylko tych, które je poprzedzają czy następują po nim. Dzięki temu jest w stanie lepiej zrozumieć niuanse i znaczenie zapytań, szczególnie w przypadku tych złożonych i zadawanych w języku naturalnym. Wprowadzenie BERT wymaga od twórców jeszcze większego skupienia się na tworzeniu naturalnych, dobrze napisanych treści, które odpowiadają na konkretne potrzeby użytkowników.

Opracowany przez współzałożycieli Google: Larry’ego Page’a i Sergeya Brina, jest jednym z fundamentalnych algorytmów używanych przez wyszukiwarkę do ustalania rankingu stron internetowych w wynikach wyszukiwania. Mimo że od czasu jego stworzenia w 1996 roku PageRank ewoluował i stał się znacznie bardziej złożony, nadal odgrywa kluczową rolę. Ocenia autorytet witryny na podstawie liczby oraz jakości linków przychodzących (backlinks). Idea polega na tym, że serwis jest uważany za wartościowy i użyteczny, jeśli linkują do niego inne strony, szczególnie te, które same mają wysokie miejsce w rankingu.

Z reguły więcej linków przychodzących oznacza wyższy PageRank, ale równie ważna jest jakość tych odnośników. W początkowych latach istnienia Google algorytm był łatwiejszy do manipulowania poprzez techniki, takie jak tworzenie sztucznych sieci linków. Jednak z czasem wprowadzono dodatkowe wytyczne i ulepszenia (Panda i Pingwin), które pomagają zniwelować próby nadużyć i zapewniają, że wysoki PageRank jest przyznawany stroną rzeczywiście wartościowym.

Obecnie PageRank jest jednym z setek czynników, które Google bierze pod uwagę przy ustalaniu rankingu stron. Inne aspekty obejmują jakość treści, odpowiedniość słów kluczowych, użyteczność witryny dla użytkowników, szybkość ładowania strony i wiele innych.

Algorytm Page Layout / Above the Fold, wprowadzony przez Google w 2012 roku, jest ukierunkowany na przejrzystość układu strony internetowej, szczególnie w odniesieniu do treści widocznych dla użytkownika zaraz po załadowaniu witryny. Above the fold to obszar, który wyświetla się odbiorcy bez konieczności przewijania. Algorytm ocenia, czy na tej części serwisu znajduje się wystarczająco dużo wartościowych informacji, czy jest zdominowana przez reklamy lub inne elementy, które mogą utrudniać dostęp do faktycznej zawartości.

Głównym celem Page Layout jest penalizowanie stron, które są przesycone ilością komunikatów reklamowych „nad krawędzią” – „above the fold”. Mogą one doświadczyć spadku w rankingu wyszukiwania. Lepiej oceniane są za to witryny, które oferują dobry bilans między reklamami a treścią, zwłaszcza w górnej części serwisu. Chodzi o to, aby użytkownicy mogli łatwo znaleźć informacje, których szukają, bez konieczności przebijania się przez nadmierne ilości reklam.

W praktyce, algorytm Page Layout zmusza twórców stron internetowych do zastanowienia się nad przejrzystym i przyjaznym użytkownikom układem witryny.

Algorytm Pirat, znany również jako Google Pirate Update, został wprowadzony przez w 2012 roku. Jego głównym celem jest zmniejszenie widoczności stron internetowych, które naruszają prawa autorskie, w wynikach wyszukiwania. Kieruje swoją uwagę na witryny, które zostały zgłoszone na podstawie DMCA (Digital Millennium Copyright Act). Często zawierają nielegalnie udostępniane treści, takie jak filmy, muzyka, książki czy oprogramowanie. Gdy serwis jest wielokrotnie zgłaszany i uznawany za naruszający przepisy, algorytm może znacząco obniżyć jego pozycję w rankingu, co prowadzi do spadku ruchu na takiej stronie.

Zadaniem algorytmu Pirat jest zniechęcanie do udostępniania i korzystania z treści cyfrowych naruszających prawa autorskie, a jednocześnie promowanie legalnych i etycznych działań. Przy ocenie stron www liczy się zatem: unikalność contentu, reputacja witryny, jakość źródeł oraz linkowanie z wiarygodnych serwisów.

Phantom nie jest oficjalną nazwą konkretnego algorytmu ogłoszonego przez Google, ale raczej terminem stworzonym przez społeczność SEO i analityków internetowych do opisania niewyjaśnionych zmian w rankingu, które zdarzały się okresowo. „Odnosi się do serii aktualizacji wytycznych, które nie zostały oficjalnie potwierdzone przez Google, ale miały znaczący wpływ na wydajność niektórych witryn.

Choć szczegóły aktualizacji Phantom nie są dokładnie znane, wiele spekulacji wskazuje na to, że koncentrują się na jakości treści na stronie. Warto zatem unikać upychania tekstów słowami kluczowymi, nadmiernych i irytujących reklam, mało wartościowych informacji itp.

Phantom odnosi się bardziej do spekulacji branżowych niż do konkretnego, oficjalnie ogłoszonego algorytmu. Jednakże, zdarzenia te przypominają, że Google nieustannie pracuje nad doskonaleniem swoich wytycznych, co może nieoczekiwanie wpływać na rankingi stron internetowych. Dla właścicieli witryn i specjalistów SEO podkreśla to znaczenie stałego monitorowania wydajności serwisu i dostosowywania się do najlepszych praktyk wyszukiwarki.

Algorytm Exact Match Domain (EMD) Update to aktualizacja wprowadzona przez Google w 2012 roku, mająca na celu zmniejszenie nieuzasadnionej przewagi rankingowej, jaką domeny z dopasowaniem ścisłym miały w wynikach wyszukiwania. Przed tą zmianą, witryny z nazwami adresów dokładnie odpowiadającymi popularnym frazom wyszukiwania często cieszyły się wyższym rankingiem, nawet jeśli ich treść nie była wysokiej jakości.

Algorytm EMD nie penalizuje wszystkich stron z dokładnie dopasowanymi nazwami domen. Serwisy, które mają wysokiej jakości treść i dbają o doświadczenia użytkownika (UX), nadal mogą osiągać dobre wyniki w wyszukiwarce. Aktualizacja podkreśla znaczenie inwestowania w długoterminowe strategie SEO, które skupiają się na jakości treści i ogólnej użyteczności strony, a nie na szybkich i często krótkotrwałych taktykach, jak wybór dokładnie dopasowanej nazwy domeny.

To nazwa jednej z aktualizacji algorytmu Google, która została wprowadzona w czerwcu 2013 roku w celu identyfikowania i karania stron internetowych zwiększających swoją widoczność w wynikach wyszukiwania poprzez wykorzystywanie technik spamerskich (Black Hat SEO). Dotyczy to zwłaszcza branży finansowej (pożyczki krótkoterminowe, czyli tzw. chwilówki), a także związanej z hazardem i pornografią.

W przeciwieństwie do innych aktualizacji Google, które są bardziej ogólne, algorytm Payday Loan był skoncentrowany na bardzo konkretnej grupie zapytań, które często były celem agresywnych i manipulacyjnych praktyk SEO, takich jak nadmierne używanie słów kluczowych, ukryte teksty, słabej jakości linki. Służy do bardziej precyzyjnego dopasowania wyników wyszukiwania, aby użytkownicy otrzymywali bardziej trafne i wiarygodne informacje.

Gołąb (Pigeon) to aktualizacja algorytmu wyszukiwania Google, która została wprowadzona w lipcu 2014 roku. Jej głównym celem jest poprawa jakości i trafności lokalnych wyników wyszukiwania. Oznacza to, że gdy użytkownik szuka czegoś w swojej okolicy, odpowiedzi będą bardziej zgodne z jego rzeczywistym miejscem zamieszkania. Jako że wiele zapytań lokalnych pochodzi z urządzeń mobilnych, aktualizacja Gołąb podkreśla potrzebę posiadania stron internetowych przyjaznych dla tabletów i smartfonów.

Dzięki tej aktualizacji lokalne firmy, które wcześniej nie zajmowały wysokiej pozycji w rankingu, mają większą szansę na pojawienie się w TOP3, pod warunkiem, że ich strony internetowe zostaną zoptymalizowane pod kątem SEO. Liczą się więc tutaj standardowe czynniki, takie jak: autorytet witryny, dopasowanie słów kluczowych, User Experience itp. Aktualizacja poprawiła również integrację wyników wyszukiwania z Google Maps, co oznacza, że firmy z dobrze zoptymalizowanymi wizytówkami mają szansę na wyższą pozycję w rankingu.

Mobilegeddon, znany również jako Mobile Friendly Update lub Mobile First Index, to znacząca aktualizacja algorytmu wyszukiwarki Google, wprowadzona w kwietniu 2015 roku. Głównym jej założeniem było zwiększenie znaczenia responsywności stron internetowych. Premiowane są witryny zoptymalizowane dla urządzeń mobilnych – dobrze wyświetlają się na smartfonach i tabletach oraz są łatwe w obsłudze na mniejszych ekranach.

Ta aktualizacja stosuje nieco odmienne wytyczne dla wyszukiwania na urządzeniach mobilnych i desktopowych. Na wyższą pozycję w rankingu mają szansę zwłaszcza te serwisy, które automatycznie dostosowują swój layout do rozmiaru ekranu. W kolejnych latach Google zaczął implementować koncepcję Mobile First Indexing, co oznacza, że korzysta głównie z wersji mobilnej strony internetowej do indeksowania i ustalania rankingu. To podkreśla, jak ważne stało się posiadanie responsywnej witryny.

Serwisy nieprzyjazne dla urządzeń mobilnych mogą odnotować spadek ruchu, ponieważ użytkownicy mają trudności z nawigacją i interakcją na małych ekranach. Algorytm motywuje jednak właścicieli stron www do aktualizowania swoich witryn, aby w pełni odpowiadały na potrzeby współczesnych użytkowników, którzy w coraz większym stopniu sięgają po tablety i smartfony do przeglądania Internetu.

Głównym celem Pandy jest promowanie wysokiej jakości treści w wynikach wyszukiwania, jednocześnie penalizując mało wartościowe strony, które nie są użyteczne dla odbiorców. Algorytm pomaga w identyfikowaniu i obniżaniu rankingu witryn, które zawierają spam, wewnętrzne i zewnętrzne duplikaty treści lub są przeładowane słowami kluczowymi. Preferuje serwisy, które oferują oryginalny content i unikalne informacje. Bierze pod uwagę autorytet strony, oceniając, czy treść jest tworzona przez ekspertów w swojej dziedzinie.

Panda ocenia witryny także pod kątem użyteczności i przyjazności dla odbiorców, w tym łatwości nawigacji i dostępności informacji. Strony, które zapewniają pozytywne doświadczenia są lepiej oceniane i zdobywają większą widoczność w wynikach wyszukiwania. Algorytm ceni również regularne aktualizowanie treści i ogólną strukturę serwisu.

Panda analizuje treść stron internetowych, aby ocenić jej jakość. Skupia się na promowaniu użytecznego i unikalnego contentu, co zmusza właścicieli witryn do publikowania wartościowych i merytorycznych opisów, artykułów blogowych, poradników itp. Dzięki temu użytkownicy mogą oczekiwać lepszych i bardziej wiarygodnych informacji podczas wyszukiwania w Google.

Serwisy z niskiej jakości treścią, które stosują keyword stuffing, duplikację tekstów lub thin content, są penalizowane przez Pandę. To oznacza, że mają mniejsze szanse na osiągnięcie wysokich pozycji w wynikach wyszukiwania. W ten sposób algorytm zwalcza techniki manipulacyjne Black Hat SEO.

Panda ocenia jakość całej witryny, a nie tylko pojedynczych stron, co oznacza, że serwis musi oferować wysokiej jakości treści, aby dobrze pozycjonować się w wynikach wyszukiwania.

Pingwin to ważna aktualizacja algorytmu Google, skoncentrowana głównie na jakości linków przychodzących do strony internetowej. Ocena ta obejmuje zarówno ilość, jak i jakość odnośników – czy są one naturalne i istotne dla treści witryny. Warto pamiętać, że od aktualizacji w 2016 roku, Pingwin działa w czasie rzeczywistym, co oznacza, że wpływ na ranking może nastąpić szybciej, gdy tylko Google zindeksuje lub przeprocesuje zmiany w serwisie lub jej profilu linkowym.

Głównym zadaniem Pingwina jest penalizowanie stron, które stosują techniki manipulacji linkami, takie jak zakup i wymiana odnośników lub korzystanie z sieci linków (link farms). W konsekwencji strony te mogą doświadczyć spadku pozycji w rankingu. Algorytm zwraca również uwagę na nadużywanie słów kluczowych w tekstach kotwiczących (anchor text).

Witryny, które zostały źle ocenione przez algorytm Pingwin, mają szansę na odzyskanie swojego rankingu poprzez usunięcie lub odrzucenie słabej jakości odnośników i poprawę swojego profilu linkowego. Algorytm Pingwin jest więc kluczowym elementem wysiłków Google na rzecz promowania etycznych praktyk SEO i zapewnienia, aby linki przychodzące do strony były naturalne i wartościowe.

Google opracowało algorytm Pingwin, aby zwalczać spam oraz manipulowanie treścią na witrynach internetowych. Jego zasadniczym zadaniem jest dostarczanie użytkownikom wyników wyszukiwania o wysokiej jakości i znaczącej wartości. Pingwin koncentruje się na identyfikacji duplikatów oraz nieużytecznych tekstów. W tym celu dokonuje:

porównania treści z innymi źródłami online – jeśli treść jest identyczna lub bardzo podobna do innych materiałów w Internecie, może to prowadzić do mniejszej widoczności w wynikach wyszukiwania.

Kluczowe jest tworzenie unikalnych, wartościowych i autentycznych treści skierowanych do użytkowników, a nie tylko do wyszukiwarek. Unikanie duplikatów i niskiej jakości linków chroni witrynę przed nałożeniem kary przez algorytm i pozwala zachować satysfakcjonującą pozycję w rankingu.

Naruszenie wytycznych Google może skutkować różnymi rodzajami sankcji ze strony wyszukiwarki, takich jak filtry lub bany, które negatywnie wpływają na obecność domeny w Internecie. W przypadku nałożenia filtra, który może być stosowany ręcznie lub przez algorytm, konsekwencje nie są tak drastyczne. Zwykle prowadzi to do spadku w wynikach wyszukiwania lub do zauważalnego zmniejszenia ruchu na stronie. W przypadku filtrów algorytmicznych, zmiany te są naturalną konsekwencją aktualizacji algorytmów, które często wprowadzają nowe wytyczne dla właścicieli stron internetowych. Specjaliści SEO z agencji są zazwyczaj w stanie szybko zidentyfikować i zareagować na te zmiany, wprowadzając niezbędne modyfikacje.

Drugi typ sankcji stosowany przez Google to ban, który jest nakładany na strony stosujące nieetyczne metody SEO. Ban oznacza całkowite usunięcie strony wraz ze wszystkimi jej subdomenami z wyników wyszukiwania. W takim przypadku wymagane jest zidentyfikowanie przyczyny sankcji i złożenie prośby o ponowne włączenie strony do indeksu wyszukiwarki.

Aby osiągnąć najlepsze rezultaty dla swojej strony internetowej, istotne jest przestrzeganie kilku podstawowych zasad znanych każdemu specjaliście SEO. Jednym z najważniejszych elementów, od którego warto się odwrócić w procesie pozycjonowania, jest praktyka ukrywania tekstu, znana jako cloaking. Polega na tworzeniu dwóch różnych wersji strony – jednej z myślą o użytkownikach, a drugiej o robotach Google.

Inną istotną kwestią są powielone treści. Obecność zarówno zewnętrznych, jak i wewnętrznych duplikatów może spowodować nałożenie sankcji przez Google. To samo dotyczy automatycznie generowanych tekstów, które nie są zgodne z zasadami SEO — nowoczesne algorytmy umożliwiają wyszukiwarkom sprawdzenie, czy tekst został wygenerowany przez narzędzie AI, czy został napisany przez profesjonalnego copywritera.

Kolejnym aspektem, na który zwracają uwagę eksperci SEO, jest nadmierne stosowanie słów kluczowych, znane jako keyword stuffing. Frazy należy umieścić w treści, atrybutach ALT, meta tagach czy linkach, ale ich ilość musi być zgodna z wytycznymi Google.

Na koniec warto wspomnieć o kiedyś popularnej, ale obecnie uznawanej za nieetyczną praktyce pozyskiwania linków. Wraz z aktualizacją algorytmu Pingwin, tworzenie farm linków, ich zakup czy korzystanie z systemów wymiany odnośników wpływa negatywnie zarówno na wizerunek marki, jak i sam proces pozycjonowania. Pozyskiwanie linków powinno więc bazować na wiarygodności i jakości. Skuteczniejszą metodą jest tworzenie artykułów gościnnych z odnośnikami do własnej strony, pozyskiwanie linków z tematycznie powiązanych serwisów oraz dbanie o ich naturalne rozmieszczenie.

Algorytm Koliber (Hummingbird), wprowadzony przez Google w 2013 roku, odegrał kluczową rolę w ewolucji wyszukiwania semantycznego. Jest to zaawansowana metoda przetwarzania zapytań, która pozwala Google lepiej zrozumieć intencje użytkowników. Zamiast skupiać się tylko na poszczególnych słowach kluczowych, Koliber analizuje całe wyrażenie, dzięki czemu lepiej sobie radzi z synonimami i wyrazami bliskoznacznymi.

W erze wyszukiwania głosowego i naturalnych form komunikacji, Koliber został zaprojektowany do efektywnej interpretacji pytań zadawanych w formie rozmowy. Pozwala to na skuteczniejsze radzenie sobie z dłuższymi i bardziej złożonymi wypowiedziami, które są bardziej typowe dla mowy niż dla pisanej formy wyszukiwania.

Koliber jest odpowiedzialny za sposób, w jaki Google przetwarza wyniki wyszukiwania. Koncentruje się na interpretacji intencji stojącej za pytaniem użytkownika, starając się dokładnie zidentyfikować, czego użytkownik szuka, zamiast ograniczać się do wyświetlania stron, które zawierają tylko konkretne słowa kluczowe. Algorytm ten bierze również pod uwagę kontekst wyszukiwania, uwzględniając czynniki takie jak lokalizacja internauty, jego poprzednie wyszukiwania, czas oraz inne istotne informacje, które mogą wpływać na to, czego poszukuje.

Dla właścicieli witryn algorytm Koliber oznacza, że ważniejsze jest tworzenie treści skoncentrowanych na tematach i ideach, a nie tylko na słowach kluczowych. Content powinien być bogaty w informacje i odpowiadać na różne aspekty i pytania związane z danym tematem.

Semantyczne SEO to metoda optymalizacji stron internetowych, która koncentruje się na zrozumieniu tego, czego użytkownik szuka, i dąży do kompleksowego zaspokojenia tych potrzeb. Osiąga się to poprzez dostarczenie w treściach odpowiedzi na wszystkie potencjalne pytania odbiorcy dokładnie w taki sposób, w jaki ich poszukuje. Ta metoda charakteryzuje się całościowym podejściem do optymalizacji zawartości witryny i jej struktury informacyjnej.

Początki wyszukiwania semantycznego wiążą się z aktualizacją algorytmu Koliber. Był to moment, gdy technika przetwarzania języka naturalnego (NLP) zaczęła odgrywać ważną rolę w wyszukiwarce. W tym czasie użytkownicy stali się bardziej świadomi i zaczęli stosować dłuższe, bardziej naturalnie brzmiące frazy. Google musiał więc dostosować się do tych zmian.

Koliber przyniósł szczególnie duże zmiany w wyszukiwaniach lokalnych. Od czasu jego wprowadzenia, coraz więcej wyników, oprócz standardowych linków do stron internetowych, zaczęło zawierać tzw. „local pack”, czyli wyniki z Profilu Firmy w Google.

Aby dostosować treści do algorytmu Koliber, ważne jest przewidywanie pytań, które mogą pojawiać się w wyszukiwarce. Pozwala to na tworzenie tekstów, które odpowiadają na specyficzne potrzeby użytkowników. Kluczowe jest, aby witryna była wartościowa i zawierała content o wysokiej jakości merytorycznej. Algorytm ten preferuje serwisy, które są przydatne dla odbiorców. Dlatego podczas optymalizacji strony, należy skupić się na treściach bezpośrednio odpowiadających na konkretne zagadnienia. Obecność słów kluczowych nie wpłynie negatywnie na pozycjonowanie, pod warunkiem, że zostaną one naturalnie rozmieszczone w tekście.

Pamiętając o celach Kolibra, które koncentrują się na przydatności strony dla internautów, należy tworzyć treści z myślą o rzeczywistych odbiorcach, a nie tylko o algorytmach wyszukiwarek. Używanie synonimów słów kluczowych może również pomóc w lepszej optymalizacji. Ponadto, warto wziąć pod uwagę lokalizację użytkownika (jeśli zgodzi się na jej udostępnienie), ponieważ Koliber uwzględnia ją w sytuacji, gdy treści mają związek z konkretnym regionem. Algorytm ten dąży do prezentowania wyników lokalnych tam, gdzie jest to możliwe.

RankBrain korzysta z uczenia maszynowego do analizowania zapytań użytkowników, szczególnie tych skomplikowanych lub rzadko spotykanych. Algorytm uczy się interpretować znaczenie słów i fraz w kontekście całego wyrażenia, co pozwala na lepsze dopasowanie wyników wyszukiwania do intencji odbiorców. W ten sposób pozwala na efektywniejsze przetwarzanie komunikatów formułowanych w naturalnym języku, co jest szczególnie ważne w kontekście rosnącej popularności wyszukiwania głosowego i zapytań w formie konwersacyjnej.

Algorytm RankBrain bazuje na uczeniu maszynowym i jest wykorzystywany przez Google do sortowania wyników wyszukiwania. Stanowi jeden z trzech najważniejszych czynników uwzględnianych do określania pozycji witryn w rankingu. Dzięki swojej zdolności do lepszego rozumienia zamiarów użytkowników jest przydatny w procesie optymalizacji SEO, umożliwiając bardziej precyzyjne dopasowanie zawartości do potrzeb odbiorców. Aby efektywnie wykorzystać RankBrain w SEO, kluczowe jest tworzenie unikalnych treści, które odpowiadają na zapytania użytkowników. Zastosowanie odpowiednich słów kluczowych i fraz kontekstowych jest również istotne, aby ułatwić algorytmowi zrozumienie intencji użytkownika. Ważne jest także budowanie skutecznych linków wewnętrznych i zewnętrznych, a także dbanie o szybkie ładowanie się strony.

Mówiąc najprościej, uczenie maszynowe dotyczy umiejętności programów komputerowych do imitowania inteligentnych działań ludzkich. Jest to jedna z form sztucznej inteligencji (AI), której podstawą są algorytmy mogące samodzielnie podejmować decyzje na podstawie analizy dostępnych danych, bez potrzeby wcześniejszego zaprogramowania ich do każdego konkretnego zadania.

Wyszukiwarki stosują uczenie maszynowe do rozpoznawania wzorców, które ułatwiają wykrywanie spamu lub zduplikowanych treści. Teksty o niskiej jakości często zawierają dużą ilość linków wychodzących do stron niepowiązanych tematycznie oraz nienaturalnie brzmiące frazy.

Uczenie maszynowe może również zwiększyć dokładność wyników wyszukiwania poprzez interpretację błędnie napisanych zapytań, analizowanie słów kluczowych w celu wyświetlenia bardziej kompleksowych odpowiedzi oraz rozpoznawanie różnorodnych kategorii, do których pytania mogą należeć, takich jak zakupy, aktualności, mapy itp.

Osiągnięcia w dziedzinie uczenia maszynowego związane są z takimi technologiami, jak sztuczna inteligencja, sieci neuronowe, uczenie głębokie oraz algorytmy oparte na analizie danych. Te zaawansowane narzędzia mogą znacząco przyczynić się do podniesienia rankingu strony w Google. Stosując je do optymalizacji zawartości, właściwego dobierania słów kluczowych i opracowywania efektywniejszych strategii marketingowych, można znacząco poprawić widoczność serwisu. Algorytmy uczenia maszynowego są przydatne w analizie danych, badaniu ruchu na stronie oraz wyłapywaniu obecnych trendów, co umożliwia głębsze zrozumienie oczekiwań i preferencji użytkowników. Ponadto, mogą one służyć do rozwijania skuteczniejszych technik SEO, na przykład poprzez optymalizację treści pod konkretne frazy kluczowe lub budowanie sieci linków do strony.

W miarę rozwoju i dojrzewania technologii uczenia maszynowego, możemy oczekiwać znaczącego wzrostu jej zdolności w obszarze modelowania predykcyjnego, a co za tym idzie – również wzrostu zastosowań. Doskonałym przykładem jest tutaj działanie serwisów takich jak Amazon, gdzie produkty są rekomendowane konsumentom na podstawie ich poprzednich zachowań. To bezpośrednio wpływa na ich doświadczenia jako użytkowników. Jednakże, uczenie maszynowe ma potencjał do rozszerzenia swoich możliwości znacznie poza obecnym zakresem.

Pozwala skonstruować różne wersje CTA i stale wyświetlać je odbiorcom, bazując na ich wcześniejszych preferencjach. W miarę gromadzenia większej ilości danych o klientach system może oferować bardziej twórcze podejście do różnych problemów i zagadnień. Wraz z dodawaniem nowych opisów produktów lub usług będziemy w stanie zrozumieć, jakie treści i zdjęcia cieszyły się największą efektywnością.

Dzięki uczeniu maszynowemu zorientujemy się, że lojalni klienci odpowiadają na pewne informacje inaczej niż nowi nabywcy. To z kolei pozwoli lepiej dostosować strukturę strony do ich różnych wymagań. Automatyczne monitorowanie najważniejszych aspektów SEO przekracza ludzkie możliwości percepcji, a warto pamiętać, że proces pozycjonowania staje się coraz bardziej złożony i konieczne jest wdrożenie zaawansowanej analityki.

Uczenie maszynowe pomaga algorytmom Google w wyświetlaniu odpowiednich wyników, nawet jeśli użytkownik zrobi literówkę, a jego zapytanie jest rozbudowane. Systemy bazujące na machine learning potrafią wykryć i poprawić ewentualne błędy poprzez rozpoznawanie ciągu liter i dopasowanie znanego sobie słowa. Posiada bowiem informację o tym, w jaki sposób użytkownicy mogą się mylić.

Algorytmy wspierane przez technologię uczenia maszynowe wpływają na widoczność strony w wynikach wyszukiwania. Jest to szczególnie ważne w kontekście kampanii SEO. Odpowiednio zoptymalizowana witryna, zawierająca treści spełniające wytyczne Google, ma szansę na wysoką pozycję w rankingu. Dobre techniki pozycjonowania White Hat SEO dodatkowo działają na korzyść naszej strony internetowej. Jeżeli content w pełni odpowiada na potrzeby i zapytania użytkowników, może wybić się na tle konkurencyjnych serwisów, niezależnie od tego, czy prowadzimy blog, sklep e-commerce czy promujemy usługi online.

BERT potrafi zrozumieć kontekst zapytań użytkowników dzięki kilku kluczowym mechanizmom:

BERT jest to jedno z najbardziej zaawansowanych narzędzi do analizy języka naturalnego stosowanych w wyszukiwarkach.

Modele językowe starszego typu, jak Word2Vec lub GloVe, bazują na analizie kontekstu jednokierunkowego, czyli poprzedzającego dane słowo. W przeciwieństwie do nich, BERT stosuje analizę dwukierunkową, co oznacza, że uwzględnia kontekst poprzedzający oraz następujący po danym słowie. To pozwala mu na głębsze zrozumienie znaczenia i relacji w obrębie całego zdania.

BERT poddawany jest treningowi na obszernej bazie danych tekstowych, obejmującej różnorodne źródła, takie jak artykuły, książki czy strony www. W ramach tego procesu nabywa umiejętności rozumienia kontekstu słów użytych w zapytaniu. Ten model może być adaptowany do szerokiego zakresu zadań, w tym klasyfikacji tekstu, identyfikacji nazw własnych czy tłumaczenia maszynowego.

Jedną z głównych funkcji, jaką oferuje algorytm BERT, jest tworzenie tzw. embeddingów, czyli zanurzeń, które nadają słowom i zdaniom wektorowe formy reprezentacji. Wykorzystywane są do oceny podobieństwa semantycznego między słowami, generowania sugestii, a także wykonania innych zadań związanych z przetwarzaniem języka naturalnego.

W kontekście SEO BERT poprawił sposób, w jaki są interpretowane długie i specyficzne frazy typu long tail. Firmy, które dostosowują swoje treści do bardziej szczegółowych i unikalnych słów kluczowych, mogą zauważyć wzrost ruchu na swoich stronach. Jest on znacznie bardziej celowany i wartościowy, ponieważ istnieje większe prawdopodobieństwo, że witryna odpowiada na konkretną potrzebę użytkownika i przyciąga klientów zdecydowanych na skorzystanie z oferty.

BERT kładzie również nacisk na wysokiej jakości treści. Warto więc tworzyć teksty w naturalnym, zrozumiałym języku, dzięki czemu będą łatwiejsze do zrozumienia i lepiej oceniane przez roboty Google. Artykuły, opisy czy poradniki powinny w pełni odpowiadać na konkretne zapytania użytkowników. Treści, które mają bogaty kontekst i są szczegółowe, osiągają wyższą pozycję w rankingu.

Regularne śledzenie aktualizacji algorytmów Google jest ważne z kilku powodów, które mają istotny wpływ na optymalizację stron internetowych pod kątem wyszukiwarek oraz ogólną widoczność w Internecie. Niektóre zmiany mogą wprowadzać nowe wytyczne dotyczące tego, co jest uważane za dobre praktyki SEO. Nieświadomość najnowszych aktualizacji może prowadzić do niezamierzonych naruszeń, które skutkują nałożeniem kar.

Regularne aktualizacje algorytmów często odzwierciedlają zmieniające się zachowania użytkowników i nowe technologie. Bycie na bieżąco pozwala na dostosowanie treści do aktualnych trendów i preferencji internautów. Ponadto jest kluczowe dla utrzymania lub poprawy pozycji strony w wynikach wyszukiwania. Śledzenie zmian pozwala także na utrzymanie konkurencyjnej pozycji w porównaniu z innymi witrynami, które mogą nie być świadome lub nie reagują na te aktualizacje.

Nowoczesne algorytmy Google, takie jak BERT, coraz bardziej polegają na zaawansowanych technologiach AI i uczenia maszynowego. Zrozumienie ich wpływu na SEO jest kluczowe dla skutecznej optymalizacji i sukces w wyszukiwarce.

Dostosowanie się do zmian w algorytmach wymaga proaktywnego podejścia i ciągłej adaptacji strategii pozycjonowania. Przede wszystkim warto być na bieżąco z oficjalnymi ogłoszeniami Google oraz branżowymi wiadomościami SEO. Należy monitorować wydajność swojej strony internetowej za pomocą narzędzi analitycznych, aby zidentyfikować, jakie aktualizacje algorytmów wpłynęły na pozycję witryny. Konieczne jest również tworzenie wysokiej jakości, wartościowych i unikalnych treści, które odpowiadają na konkretne potrzeby i pytania użytkowników. Google stale dąży do promowania contentu najbardziej użytecznego dla odbiorców. Musimy także mieć pewność, że serwis jest odpowiednio zoptymalizowany dla urządzeń mobilnych, ponieważ coraz więcej użytkowników korzysta z wyszukiwarki na smartfonach i tabletach.

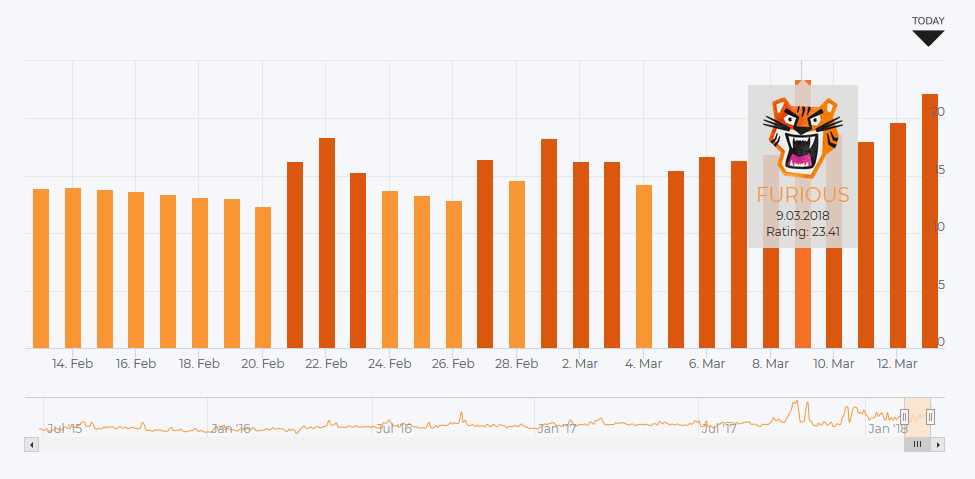

Czasami Google zapowiada planowane aktualizacje algorytmu, co daje specjalistom SEO szansę na wprowadzenie zmian na stronach internetowych przed ich wdrożeniem. W takich przypadkach osoby zajmujące się optymalizacją mają możliwość dostosowania witryn do nowych wytycznych. Jednak w większości przypadków Google nie ogłasza z góry wprowadzonych aktualizacji algorytmów, co sprawia, że przygotowanie się na nie jest niemożliwe. Często nawet po wprowadzeniu zmian brakuje jasnych informacji na temat tego, co dokładnie uległo modyfikacji. Spadek pozycji w wynikach wyszukiwania nie zawsze musi więc być wynikiem błędów w strategii SEO. W takich sytuacjach ważne jest, aby zdiagnozować problem i podjąć odpowiednie działania w celu odzyskania wysokich pozycji.

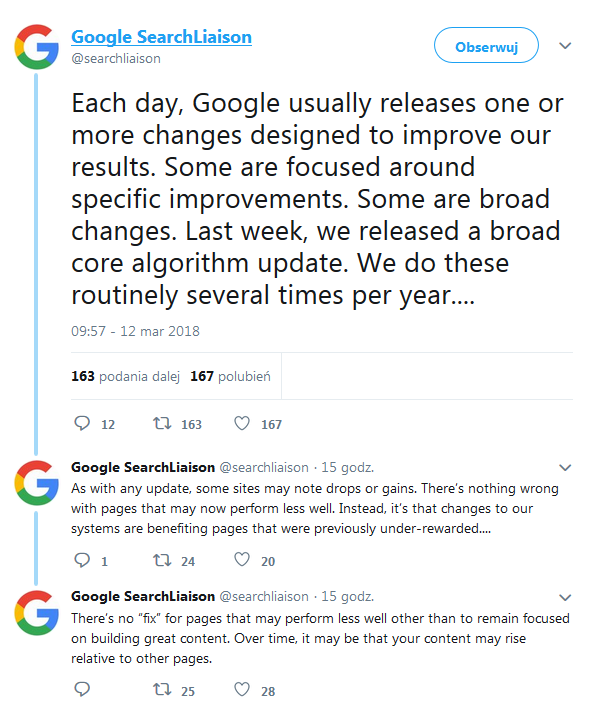

Zmiany w algorytmie zawsze wywołują większe wahania w wynikach wyszukiwania – spadki pozycji jednych serwisów i wzrosty innych. Google informuje, że utrata miejsca w rankingu nie oznacza, że ze stroną dzieje się coś niedobrego – po prostu inne witryny mogły zostać lepiej ocenione przez roboty wyszukiwarki rankingujące według nowego modelu.

Jakie jest rozwiązanie na spadki? Google wspomina o rozwijaniu treści na stronie i tworzeniu angażujących tekstów, które w przyszłości mogą dać serwisowi przewagę nad innymi witrynami w wynikach wyszukiwania. Po raz kolejny content marketing i SEO copywriting to szansa na skuteczne wsparcie pozycjonowania.

W przyszłości możemy oczekiwać kilku innowacji, które będą miały wpływ na wytyczne Google. Algorytmy stają się coraz bardziej zaawansowane i samodzielne, co sprawia, że wyszukiwarki będą efektywniej rozumieć kontekst i intencje użytkowników. Z uwagi na rosnącą popularność asystentów głosowych, optymalizacja pod kątem wyszukiwania głosowego również nabiera na znaczeniu. Ponadto rozwój technologii rzeczywistości rozszerzonej (AR) i wirtualnej (VR) może całkowicie zmienić sposób wyszukiwania informacji, wprowadzając innowacyjne sposoby interakcji z treściami.

Jak przygotować się na zmiany w algorytmach Google? Należy regularnie aktualizować swoją wiedzę na temat SEO i trendów w wyszukiwarkach – śledzić branżowe blogi, uczestniczyć w konferencjach i webinariach, czytać oficjalne ogłoszenia giganta z Mountain View oraz inne wiarygodne źródła.

Analiza zmian w algorytmach Google wskazuje, że czynniki rankingowe coraz bardziej koncentrują się na jakości treści. Dlatego zgodnie z aktualnymi wytycznymi, tworzenie tekstów, które są wartościowe, autentyczne i przydatne, jest niezbędne dla osiągnięcia sukcesu w SEO. Nadal ważne jest podkreślanie ekspertyzy, autorytetu i wiarygodności zarówno treści, jak i samych stron internetowych. To właśnie te kryteria EAT odgrywają kluczową rolę w ocenie wartości serwisu przez wyszukiwarki.

Mamy do czynienia z wieloma mitami i nieporozumieniami dotyczącymi algorytmów Google, które mogą wprowadzać w błąd osoby zajmujące się SEO. Często pojawia się twierdzenie, że istnieje jeden lub kilka najważniejszych czynników rankingowych, takich jak linki zwrotne lub słowa kluczowe. W rzeczywistości Google wykorzystuje setki aspektów do ustalania pozycji stron i nie ma jednego „magicznego” wyznacznika. Kolejne przestarzałe i błędne przekonanie można zawrzeć w równaniu: więcej słów kluczowych = lepsze pozycjonowanie. Jest to podejście znane jako keyword stuffing, które obecnie może przynieść więcej szkody niż pożytku, ponieważ algorytmy Google skupiają się bardziej na jakości treści i kontekście niż na samej liczbie fraz. Niektórzy również mylnie zakładają, że wytyczne wyszukiwarki są statyczne. W rzeczywistości Google regularnie aktualizuje swoje algorytmy, niekiedy nawet kilka razy w roku.

Z naszych obserwacji wynika, że update głównego algorytmu dotyczył głównie linków. Po raz kolejny Google wskazuje, aby zwracać uwagę na jakość odnośników i budować wartościowy profil linków zwrotnych. W pozycjonowaniu należy nastawić się na kompleksowe działania – strony, które skupiały się jedynie na rozbudowie contentu, nie zaliczyły większych wzrostów ani spadków, co wskazuje, że treść ma duże znaczenie dla pozycji w wynikach wyszukiwania, ale w połączeniu z optymalizacją serwisu i odpowiednią strategią link buildingu może przynieść naprawdę dobre efekty.

02.04.2025

|

czas czytania: 5:00 min

|

Inne

02.04.2025

|

czas czytania: 5:00 min

|

Inne

31.03.2025

|

czas czytania: 5:00 min

|

Inne

31.03.2025

|

czas czytania: 5:00 min

|

Inne

20.03.2025

|

czas czytania: 2:00 min

|

SEO

20.03.2025

|

czas czytania: 2:00 min

|

SEO